はじめに:古典的限界を超える量子的アプローチ

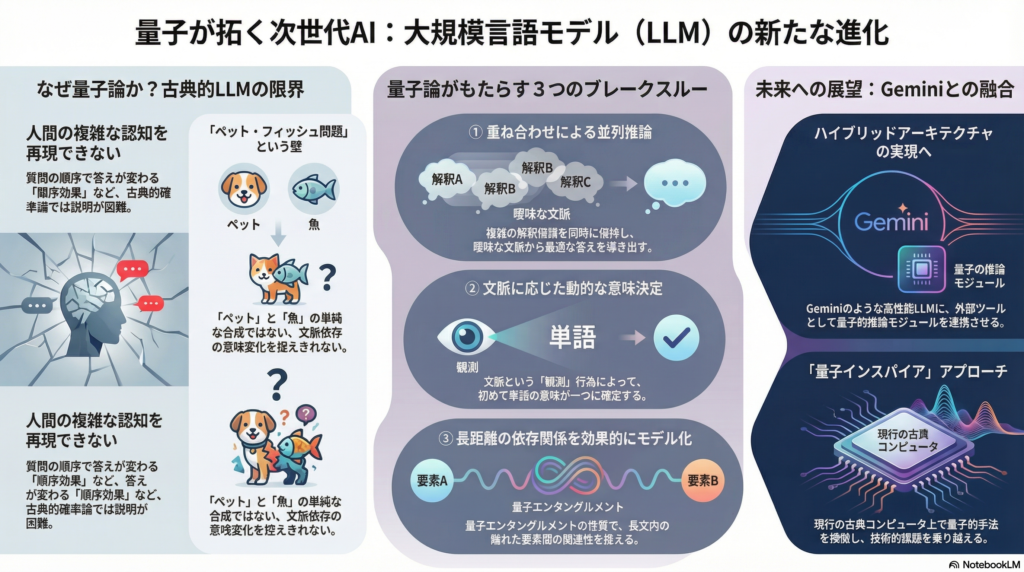

大規模言語モデル(LLM)の発展は目覚ましいものの、人間の言語理解が持つ繊細な文脈依存性や非線形的な意思決定プロセスを完全に再現することには課題が残されています。従来の言語モデルは主にベイズ的推論を基盤としていますが、人間の認知において観測される「順序効果」や「文脈依存性」といった現象は、古典的確率論では説明が困難です。

ここで注目を集めているのが、量子確率論に基づく認知モデルとLLMの融合という新しいアプローチです。量子確率モデルは、従来のフレームワークでは捉えきれなかった複雑な認知現象を数理的に説明できることが示されており、最先端のLLMが直面する組合せ的問題に対する新たな解決策として期待されています。

本記事では、量子ベイズ更新を活用した言語生成モデルの最新研究動向を整理し、Google DeepMindのGeminiをはじめとするLLMアーキテクチャへの応用可能性について詳しく解説します。

量子ベイズ更新による言語生成モデルの革新

量子回路を活用した生成モデルの提案

量子力学の原理を取り入れた生成モデルの研究は、近年着実に進展しています。特に注目すべきは、Gaoらが2022年に発表した**Bayesian Quantum Circuit(BQC)**の研究です。彼らはベイズネットワークの量子拡張により、古典的モデルでは捉えにくい量子相関(絡み合いや文脈性)を利用して生成能力を向上させることに成功しました。

具体的には、n-gramモデルを行列積状態(MPS)で実装した量子回路に拡張することで、古典的n-gramでは表現できない非局所的な確率分布を理論的に実現しています。数値実験においても、従来のモデルと比較してテキストデータセットに対する尤度の向上が確認されており、量子手法が言語生成に貢献できる可能性が実証されています。

量子版ベイズ更新の特徴

量子測定の理論において、事後状態は観測結果に応じて射影(またはPOVM)によって更新されます。量子的ベイズ更新の特徴的な点は、従来の信念状態が完全に破棄されず、測定結果とアドミクスチャ的に組み合わさるという性質です。

この性質はディープラーニングにおけるスキップ結合にも通じる直感的な効果を持ち、段階的な情報の統合を可能にします。量子ベイズネット(QBN)では古典確率の代わりに複素確率振幅を用いるため、観測や意思決定のたびにネットワーク全体の状態がユニタリまたは測定によって変化し、逐次的な言語生成への応用が期待されています。

Hidden Quantum Markov Modelsの展開

Srinivasanらは2018年に**Hidden Quantum Markov Models(HQMM)**を提案し、連続的な確率分布を密度行列で保持するアプローチを示しました。彼らのヒルベルト空間埋め込みによるHQMM(HSE-HQMM)は、シーケンスモデリングにおいて従来のLSTMや確率的状態空間モデルに匹敵する性能を示しており、ベイズ推論をヒルベルト空間上で拡張する有力な手法となっています。

HQMMでは量子的なベイズ更新(密度行列の更新)を繰り返すことで系列データをモデル化し、次単語予測などの言語生成タスクへの応用が検討されています。

量子確率論とNLPの統合:QNLPの最前線

Quantum Natural Language Processingの二つの方向性

量子論的発想をNLPに取り入れる研究は、**Quantum Natural Language Processing(QNLP)**として近年活発化しています。QNLPには主に二つの方向性が存在します。

一つは量子計算プラットフォームを用いた言語処理です。Coeckeらによる量子回路上での文意味解析(DisCoCatモデル)が知られており、量子コンピュータ上で単語をヒルベルト空間のベクトルとして符号化し、文脈に応じた合成を行う試みが進められています。また、変分量子回路で言語モデルを構築する研究も登場しています。

もう一つは量子確率モデルを理論的枠組みとして活用するアプローチです。これは量子コンピュータを必ずしも必要とせず、古典計算機上で量子的手法を模倣する「量子インスパイア」な手法も含まれます。

QLens:Transformerの量子的再解釈

最近の注目すべき研究として、**QLens(Quantum Lens)**という手法があります。これはTransformerの各層をユニタリ作用素、中間表現を量子状態ベクトル、最終出力の確率をボルン規則で得るものとみなし、Transformerの推論過程を量子的に再解釈するフレームワークです。

QLensでは隠れ層の変換をシュレディンガー方程式に従うユニタリな状態遷移として扱い、最終的な出力分布は観測(測定)によって得られるとモデル化します。これは物理学の視点でTransformerを理解する初歩的なフレームワークであり、各層が予測に与える影響を可視化する実験も報告されています。

量子認知学のNLPへの応用

量子認知学(Quantum Cognition)の成果もNLPに応用されています。量子認知学では、ヒルベルト空間上の状態ベクトルや非可換な射影測定を用いて、人間の概念の組み合わせや文脈効果、意思決定のパラドックスを説明します。

例えば、「ペット・フィッシュ問題」(「ペット」と「フィッシュ」という概念を組み合わせると予想外のカテゴリ反応が生じる現象)において、古典論では説明困難な文脈依存の意味変化が観測されますが、Aertsらはこれが量子的文脈性によって説明できることを示しました。

Bell不等式違反と非古典的相関

Bruzaらの研究では、人間が顔写真の印象を評価する実験でBell不等式(CHSH不等式)の違反、すなわち非古典的な相関が確認されています。これは意味解釈のプロセスそのものが量子的特性(測定文脈に依存し事前に値が確定しない性質)を持つ可能性を示唆しています。

興味深いことに、LLMを用いた実験でも文脈解釈においてCHSH不等式の体系的な違反が確認されており、人間と同様にLLM内部でも意味の文脈依存的な実現が起きている可能性が報告されています。

Geminiアーキテクチャと量子的推論の融合可能性

Geminiの革新的アーキテクチャ

Google DeepMindのGeminiは、最新の大規模言語モデルファミリーとして、マルチモーダル対応や大規模コンテキスト処理、エージェント的動作など高度な機能を備えています。Gemini 1.5ではMixture-of-Experts(MoE)方式を組み込んだ革新的アーキテクチャが採用され、最大100万トークンという非常に長いコンテキストウィンドウを実現しました。

さらにGemini 2.0以降では、chain-of-thoughtと呼ばれる思考過程の明示的分解によるステップ推論が導入され、モデル自体が回答を出力する前に複数ステップで内部推論を行う「思考モード(Deep Think mode)」が実装されています。

量子的要素の組み込み可能性

現時点でGeminiの内部は従来型のディープニューラルネットワークであり、量子状態や量子ゲートを直接扱うわけではありません。しかし、GeminiのようなLLMアーキテクチャに量子的要素を組み込む余地は存在します。

一つの展望は、GeminiのMoE的なモジュール構造やツール使用インターフェースを活用し、量子的な推論モジュールを外部連携させる方法です。GeminiはAPI経由で外部ツールやモデルを呼び出す機能を備えており、この枠組みに基づき量子コンピュータ上で動作するサブモジュールを組み込むことが考えられます。

ヒルベルト空間埋め込みとしての長大コンテキスト

Geminiの持つ長大なコンテキスト処理能力(100万トークン)と高次元表現は、一種の大規模なヒルベルト空間埋め込みとみなすこともできます。重み空間で学習されたベクトル表現同士の内積は量子的な状態重ね合わせにも類似しており、LLM内部での注意機構は動的に文脈依存の関連性を計算する点で、量子モデルの「状態が文脈に応じて射影される」性質と対応づけることが可能です。

Geminiの自己注意層は文脈に応じて単語の意味ベクトルを更新しますが、この更新を量子的状態更新(測定とユニタリ変換の組み合わせ)として解釈する研究も進められています。

統合アーキテクチャにおける新たな推論パラダイム

重ね合わせ状態による並列推論

量子認知モデルとLLMを統合したアーキテクチャでは、推論において新たなアプローチが可能になります。量子モデルの導入により、LLMは重ね合わせ状態で複数の仮説を保持しながら推論を進めることができます。

従来のLLMもビームサーチなどで複数候補を内部的に保持しますが、量子的アプローチではそれを原理的に並列表現し、干渉効果で非自明な候補の絞り込みを行える可能性があります。例えば、質問応答シナリオで曖昧な質問に対し、量子的統合モデルは回答の候補をスーパーポジションに保持しつつ、追加の文脈情報(観測)に応じて一回の測定で答えを確定するといった振る舞いが考えられます。

動的文脈理解の実現

文脈理解において、量子モデルのコンテキスト依存性が真価を発揮します。量子セマンティクスの視点では、単語の意味は文脈という観測行為によって初めて定まるため、統合モデルでは文脈をヒルベルト空間上の演算(ユニタリ変換や測定)として扱い、その場で意味を動的に構築することが可能です。

多義語や曖昧な指示詞も量子的状態として保留し、十分な文脈が与えられた時点で一意に「観測」して解釈を確定するという柔軟な文脈理解が期待できます。これは古典的LLMが事前確率に基づき早期に意味を固定してしまうことによる誤解を減らす効果がある可能性があります。

非古典的確率の実装

統合アーキテクチャでは、確率は単なる頻度的・客観的なものではなく、観測行為やエージェントの関与によって変容する主観的なものとして扱われます。LLMが次の単語の確率分布を計算する場合、古典的には事前文脈に条件付けられた固定分布を出力しますが、量子的枠組みでは、その確率は観測によってコヒーレントに変化し得ます。

技術的には、確率振幅の重ね合わせと干渉効果によって、ある解釈パスが他のパスを打ち消したり強めたりする挙動が現れます。これは一見低確率の解釈が文脈次第で急に浮上するような、人間の直感に近い挙動を再現できる可能性があります。

言語生成における量子的効果の理論的利点

表現力とモデル性能の向上

量子モデルは非局所的相関やコンテキストに依存した確率分布を表現でき、古典モデルに比べ表現力が高いことが理論的に証明されています。Gaoらの研究では、量子拡張したn-gramモデルが同サイズの古典モデルでは近似不可能な分布を生成できることを示し、実データセット上でもその優位性を確認しています。

このような表現力の差は、特に曖昧さの高い生成タスク(詩的な言い回しや創造的文章生成など)で質の高い出力をもたらす可能性があります。

長距離依存の効果的モデリング

量子エンタングルメント(絡み合い)に相当する機構を用いることで、文脈中の遠く離れた要素間の依存関係も自然に捉えることができます。従来、長文脈はTransformerのようなモデルでもメモリ制約上困難でしたが、量子モデルでは状態空間が指数的に豊かであるため、長大コンテキストでも情報を損なわず保持・相関付けできる理論的利点があります。

人間の認知に近い振る舞いの再現

量子的確率はしばしば人間の直感的判断(文脈による突然の意味変化、質問順序で答えが変わる等)を再現します。統合モデルは、例えば質問応答や対話生成でユーザの意図や感情といった観測行為を踏まえて応答内容を非線形に調整する、といった振る舞いが期待できます。

これはより一貫性がありつつ柔軟な対話を可能にし、ユーザの真意を汲み取る能力向上につながる可能性があります。

実証的エビデンス

定量的には、Hidden Quantum Markov Models(HQMM)など量子的系列モデルがLSTMや他の深層学習モデルに匹敵する性能を既に示しています。SrinivasanらのHSE-HQMMは複数の系列データセットでLSTM並みの精度を達成しつつ、連続値特徴の分布推定という利点も示しました。

さらに、BruzaらやAertsらの研究で示されたように、量子的モデルは情報検索や意思決定で古典的手法を超える説明力を発揮しています。これらは間接的ではありますが、言語生成においても量子的効果を導入することで定量的指標の改善が見込めることを示唆しています。

実装における課題と量子インスパイアアプローチ

技術的ハードルと対応策

量子モデルとLLMの統合には課題も存在します。量子力学的な計算はノイズやデコヒーレンスの問題があり、現在のNLPタスク規模で直接量子計算を行うのは技術的ハードルが高い状況です。

しかし、量子インスパイア(古典計算機上で量子的手法を模倣する)なアプローチであれば、既存ハードウェアで実証研究を進めることができます。実際、本記事で紹介した多くの研究は古典シミュレーション上で量子的手法を検証したものです。

段階的な統合戦略

今後は、これらの知見を統合したプロトタイプ的アーキテクチャを設計し、小規模な言語生成タスク(例えば限定的文脈での対話や質問応答)で性能評価を行う段階へ進むことが望まれます。

Geminiのような既存の高性能LLMと量子的推論モジュールを組み合わせるハイブリッドアプローチは、技術的実現可能性と性能向上の両面でバランスの取れた選択肢となる可能性があります。

まとめ:人間の言語理解に迫る新たなAIへの一歩

量子確率論に基づく認知モデルと大規模言語モデルの融合は、言語生成における新たなパラダイムを切り拓く可能性を秘めています。量子ベイズ更新の概念を取り入れることで、従来のLLMが苦手としてきた文脈依存的な意味解釈や非線形的な推論プロセスを改善する道が開かれています。

量子回路を用いた生成モデルは理論・実践の両面で古典的モデルを上回る結果を示しており、ヒルベルト空間上でのベイズ推論拡張が系列データモデリングで成功を収めています。Geminiのような最先端LLMは高い汎用性能を持ちながらも、そのアーキテクチャは量子的要素を取り入れる拡張性も残しており、将来的なハイブリッド実装によって更なる知能化が期待できます。

この統合アプローチは、単なる工学的性能向上だけでなく、人間の認知や意味理解のメカニズムをAIに組み込む試みでもあります。量子認知学とLLMの架橋は学際的な意義も大きく、AIと認知科学の新たな融合領域として今後の発展が期待されます。

量子計算技術の成熟と共に、量子的効果を活用した次世代言語モデルの実用化に向けた研究が加速することで、より人間らしい言語理解と生成を実現するAIへの道が開かれていくでしょう。

コメント