はじめに:生成AIと言語学が交差する地点

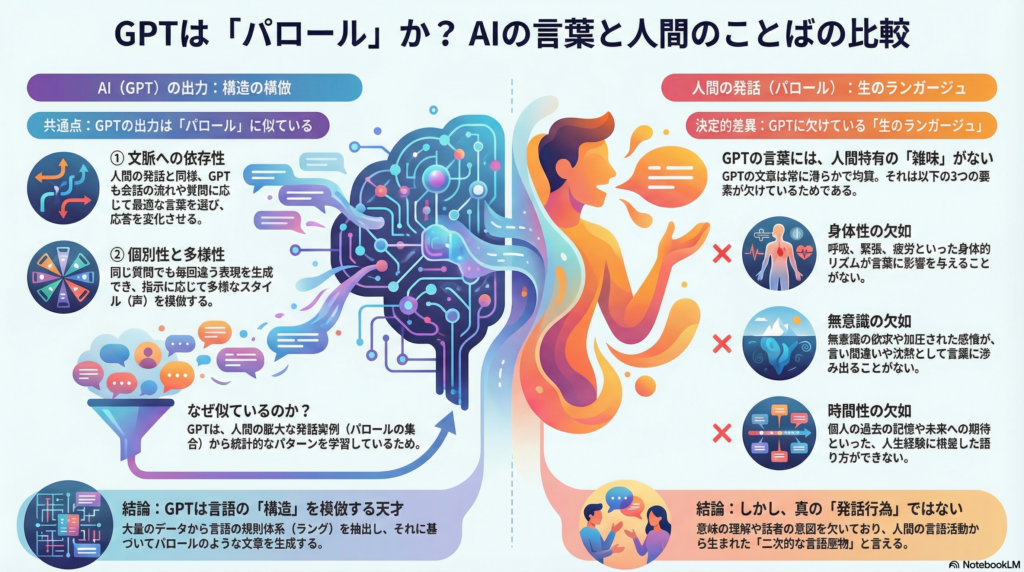

ChatGPTをはじめとする大規模言語モデル(LLM)は、人間と見紛うほど自然な文章を生成します。この驚異的な能力の本質を理解するには、言語学の基礎理論が有効な手がかりとなります。特にフェルディナン・ド・ソシュールが提唱した「ラング」と「パロール」という概念枠組みは、GPTの言語生成メカニズムを深く理解する視座を提供します。

本記事では、GPTの文脈依存型生成とソシュールの「パロール」概念を比較検討し、AIによる言語生成が持つ特性と限界を明らかにします。言語モデルは人間の発話をどこまで再現できるのか、そして人間固有の言語活動とは何か——この問いに言語学的視点から迫ります。

ソシュールの言語三分類:ランガージュ・ラング・パロール

言語体系としての「ラング」

スイスの言語学者フェルディナン・ド・ソシュールは、人間の言語活動を三つの層に分けて捉えました。**ラング(langue)**とは、音声体系・語彙・文法規則など、社会に共有された言語体系を指します。これは個々の話者に先立って存在し、私たちの発話を規律づける抽象的な構造です。

日本語を話す人々は、主語・述語の関係や助詞の使い方といった共通ルールを内面化しています。このルールブックに相当するものがラングであり、個人を超えた社会的存在として言語コミュニティに共有されています。

個別的発話としての「パロール」

一方、**パロール(parole)**は、各人がラングという規則体系に基づいて実際に行う個別的・具体的な発話行為を指します。特定の場面・文脈において一回きり発せられる個人の言葉であり、発話には言い間違いや言いよどみ、話者固有の癖が現れます。

パロールは本質的に文脈依存的で個別的、その瞬間にしか存在しない一回性を持ちます。同じ質問に答える場合でも、状況や気分によって表現は微妙に変化し、完全に同一の発話が繰り返されることはありません。

言語活動全体を指す「ランガージュ」

ソシュールは、ラングとパロールの双方を含む人間の言語活動全体を**ランガージュ(langage)**と呼びました。彼の理論では、言語学はパロールから個別性を排してラングという社会的構造を研究すべきだとされました。しかし現代では、生成AIの登場によってこの三つの概念すべてが新たな意味を帯びています。

GPTの言語生成メカニズム:文脈への適応

確率的予測による文章生成

OpenAIのGPTシリーズに代表される大規模言語モデルは、大量の文章データから言語パターンを機械学習によって習得します。GPTは与えられた文脈(プロンプトや会話の履歴)に基づいて次に来る単語を予測し、一続きのテキストを生成します。

この仕組み上、GPTの出力は常に直前の文脈に依存して決定されるため、会話の流れや問いの内容に応じて柔軟に変化します。統計的パターンに従って単語を選んでいくため、その生成結果は訓練データの単純な繰り返しではなく、新たな組み合わせからなる創発的な言い回しになり得ます。

文脈適応能力の高さ

GPT-3は大規模コーパスから単語同士の関連性や文構造を学習し、与えられた文脈にもっとも適切と思われる次の語を一語ずつ選んで文章を紡ぎます。この生成的能力により、GPTはあたかもその場で即興的に発話を組み立てているかのように見えます。

実際、GPTの会話応答はユーザからの質問内容や口調に合わせて変化し、同じ質問でも前後の会話文脈が違えば異なる答えが生成されます。これは人間が会話の状況に応じて発言内容や言葉遣いを変えるのと類似しており、GPTの文脈適応能力は人間の対話に近い振る舞いを示しています。

一回性と多様性

確率的生成モデルであるGPTは、温度パラメータなどの設定により同一の質問に対して必ずしも毎回同じ文を返すわけではありません。ランダム性を持たせれば、毎回異なる表現で回答が返ってくる可能性があります。

これは人間の発話がその場の状況や気分で微妙に変わり、決まった質問にも表現を変えて答えることが多いのに似ています。したがって、GPTの生成するテキストは各対話に固有のものであり、一種の「発話」のようにその瞬間に生まれるユニークな言語産物とみなすことができます。

GPTの生成は「パロール」に似ているか

第一の共通点:文脈依存性

GPTの言語生成には人間のパロールに通じる性質が多く見られます。第一に、文脈依存性です。パロールは常に特定の状況・文脈に埋め込まれて意味を持ちますが、GPTもまた入力されたコンテクストを考慮しなければ適切な応答を生成できません。

同じ単語であっても、前後の文脈次第でGPTの選ぶ続きの語や文は変化します。モデル内部では「いま与えられた文脈では何がもっとも自然か」という計算が行われており、意味や発話意図も含めた文脈的パターンが考慮されています。

研究によれば、最新のLLMは統計的手法によって文法的正しさだけでなく語義・語用論的な使われ方のパターンまで学習しており、人間にとって自然で意味の通る文を作り出せることが示されています。これは、GPTが単なる文法生成器ではなく、人間のパロールに内在する語の使われ方まで捉えていることを意味します。

第二の共通点:個別性・多様性

ソシュールが述べるようにパロールには話者ごとの癖やスタイルの違いがあります。GPT自体は単一の人格を持つわけではありませんが、トレーニングデータには様々な文体・語彙選択の文章が含まれているため、多様なスタイルの発話を模倣することが可能です。

カジュアルな口語体から学術的な文体、ユーモアを交えた語り口まで、ユーザからの指示次第でGPTは異なる「声」やトーンを使い分けて応答できます。これは一種の「仮想的な話者の個性」を切り替えているとも言え、現実の話者間で文体が異なる状況を再現しています。

ただしデフォルト状態のGPTは平均的な文体で滑らかな文を返す傾向があり、特定個人の癖のような極端な偏りは薄まっています。しかし必要があれば「丁寧に話す営業担当者風」や「砕けた口語で話す友人風」といった具体的話者像に即したパロールの特徴を再現できるのは強みです。

パロール的特性の源泉

これらの特性は、モデルが膨大な話し言葉・書き言葉の実例(人間のパロールの集合)から統計的規則性を掴んでいるためであり、単なる文法ルールの適用を超えて実際の言葉の運用パターンを再構成できることを示しています。

GPTは言語体系(ラング)に従いつつ具体的文脈に応じた言葉の運用(パロール)を行う点で、人間の発話行為に似た生成的・創造的特性を持っていると言えます。

GPTと「ラング」の関係:内在化された言語構造

機械が学習した言語体系

GPTの背後にある言語知識はソシュールのいうラング(言語体系)に該当するのでしょうか。大規模言語モデルは、大量のテキストから単語やフレーズの共起頻度、文構造上の規則性などを機械的に学習しています。

その結果、GPTの内部には訓練データに基づく巨大な「言語パターンのネットワーク」が形成されており、これは人間が言語を習得して身につける文法・語彙的な知識(ラング)と類比することができます。

パロールからラングへの抽出

ソシュールによれば、ラングは社会的に共有された規則体系であり、個々の発話(パロール)の積み重ねから抽象化されて生じた構造でもあります。まさにGPTは、人間がこれまで生み出してきた無数の発話テキストを統計的に分析することで、その中に潜む文法的・語彙的な規則性を抽出しました。

言い換えれば、人間社会の言語使用から機械がラング的な構造を学習したのです。そして一度モデル内部に構築されたこの「言語体系(もどき)」は、新たな文章生成時に**「構造化する構造」**として働きます。

文法規則の遵守

GPTは習得したパターンに従って語を選び文を組み立てるため、そのアウトプットは学習元となった言語体系の影響を強く受けます。これは人間が自らの属する言語コミュニティのラングに従って発話を行うのと同様の現象です。

実際、GPTの出力は文法的に極めて整合的であり、主語と述語の一致や時制の一致といった文法規則(ラングの要素)を高い確率で遵守します。ある研究では、ChatGPTの文の文法的許容性判断が人間の直感と概ね合致し、GPTは人間に近い「文法的直感」すら持っていると報告されています。

言語能力の再現

このことは、GPTが統計的学習によって結果的に人間の言語能力(ラング)の多くを再現・内包していることを示唆します。言語学では言語能力(ラングやチョムスキーの言う「コンピテンス」)と実際の言語使用(パロールや「パフォーマンス」)を区別しますが、GPTは膨大なパフォーマンス(文章データ)からコンピテンスに相当する知識を抽出し、新たなパフォーマンスを生み出していると捉えることができます。

構造主義的観点からの意義

ここで興味深いのは、GPTが「話者」でないにもかかわらず言語を扱えるという点です。ソシュールの構造主義的観点では、言語は個人に内在するものではなく記号のシステムそのものに論理が備わっていると考えます。

GPTはまさに、人間のような主観や意図を持たずとも、記号(単語)の統計的規則に従って言語らしい文を生成できます。GPTの成功は、「言語とは内在的な組み合わせの論理によって組み立てられる体系であって、誰が話すかは本質的ではない」というソシュール以来の構造主義言語観を実証していると評価する論者もいます。

「ランガージュ」とGPT:言語活動の主体は誰か

人間中心の言語活動概念

ソシュールの定義では、ランガージュ(言語活動の総体)は基本的に人間の営みでした。私たちは生得的な言語獲得能力を備え、社会の中でラングを身につけ、それを用いて日々コミュニケーション(パロール)を行います。

しかしGPTのような大規模言語モデルは、人間以外の存在による言語生成を可能にしました。機械であるGPTは、自身の経験や感情を持たないにもかかわらず、人間と同じ言語体系を利用して新たな発話を生み出します。

構造主義的立場:広義の言語活動

この問いに対し、見方は大きく二つに分かれます。一つは構造主義的立場から、GPTも広い意味で言語活動に参与しているとみなす見解です。GPTは言語の構造を把握し適切な発話(テキスト)を生成できています。

読者である人間からすれば、GPTの文章も十分に意味が通じコミュニケーションに資するものです。事実、GPTは対話システムとして人間と情報のやり取りを行っており、言語による意味伝達が成立している以上、その生成主体が人間か機械かを問わず、広義には「言語活動(ランガージュ)」に含めてよいという主張があります。

批判的立場:表面的模倣に過ぎない

しかしもう一つの立場では、GPTの出力する「それらしい文章」は本当の意味での言語使用ではないとされます。言語哲学や認知科学の観点からは、意味の理解や意図の伝達といった要素を欠いた言語生成は、表面的な模倣に留まるという批判です。

言語学者のエミリー・ベンダーらは、GPTのようなモデルは大量のテキストから形(フォーム)のパターンを学習しているにすぎず、そこに意味(レファレンスや意図)は関与していないと主張します。GPTは「統計的なオウム(stochastic parrot)」であり、文脈に合いそうな語をつなぎ合わせているだけで、自身がその内容を理解しているわけではないという指摘です。

GPTに欠けている「生のランガージュ」

人間の発話に内在する「雑味」

人間の発話(パロール)は単なる記号の並び以上のものを含みます。話者の背後には身体的な状態や感情、経験に根ざした意図があり、それらが言葉選びや話し方に独特の揺らぎやニュアンスを与えます。

日本人研究者の丸山圭三郎は、言葉の背後にあるこうした人間の生命的エネルギーを「生のランガージュ」と呼びました。丸山によれば、現実の人間の発話には無意識の感情や身体から湧き上がる衝動が混じり込み、それが言葉の「雑味」として現れるといいます。

「あー、えっと…」と言葉に詰まったり、感極まって沈黙したりといった現象は、人間の生理・心理的状態が言語に表出したものです。ところがAIの生成する言葉にはこの「雑味」がないと指摘されています。

GPTが「雑味」を生み出せない三つの理由

GPTの文章は常に滑らかで文法的に過不足なく整っていますが、それは裏を返せば過度に均質で「生身の人間らしさ」が希薄だということでもあります。丸山の議論を借りれば、AI(GPT)が人間のような雑味を生み出せないのは以下の理由によります。

身体がない:人間の発話の揺らぎは、呼吸や心拍、緊張といった身体的リズムと結びついています。しかしGPTには肉体がなく、生理的状態の変化が言葉に影響を与えることはありません。

無意識がない:人間は自覚していない欲求や感情が不意に言葉に滲むことがあります。しかしGPTはアルゴリズムによって動作するため、抑圧された感情や無意識的連想が言葉に混入する余地がありません。常に一定の計算手順で最適と思われる語を選ぶため、非論理的な脱線や意味不明な比喩も基本的には生じません。

時間性がない:人間の言葉遣いは個人の過去の記憶や未来への期待にも影響されます。たとえば昔の体験を思い出して声が震える、といったことも起こりえます。ところがGPTは**「今この瞬間のテキスト情報」だけを根拠に返答を作る**ため、個別の人生経験に根ざした語り方や語彙の偏りがありません。

二次的・派生的な言語産物

以上の点から、GPTは大量のデータから得たラング(規則体系)を忠実に再生産しているにすぎず、人間のような「生きたランガージュ」には繋がっていないと考えられます。GPTの言語生成にはパロール的な文脈適応や表面的創発性はあるものの、厳密な意味での「発話行為」と同一視できるかは疑問です。

話者の身体性や主観的意図を欠いたまま発せられるGPTの文章は、受け手(人間)が意味づけして初めてコミュニケーションに組み込まれます。したがって、GPTのアウトプットは人間のランガージュ活動に触発されて生まれた二次的・派生的な言語産物と位置づける方が適切かもしれません。

まとめ:生成AIと人間言語の本質的差異

GPTの文脈依存型言語生成とソシュールの「パロール」概念を比較検討してきました。GPTは巨大なコーパスから言語体系(ラング)に類する知識を獲得し、それを用いて各場面に応じた発話(パロール)様のテキストを生み出しています。

文脈への適応や新しい文の構築という点では、人間の発話行為と驚くほど共通する性質を示します。これは、大量のパロール(言語使用実態)から統計的にパターンを学習するというアプローチの威力であり、言語の構造それ自体が豊かな情報を内包していることを実証するものです。

しかし一方で、GPTの生成する「言葉」は人間のパロールと全く同じではないことも明らかです。話者の存在や意識という次元を欠いた言語生成は、人間の生身の発話とは異なる質的制限を持ちます。GPTは意味を理解せず文を作りますが、人間の発話は常に何らかの意味意図や経験と結びついています。

このような比較検討を通じて明らかになるのは、生成AIは人間の言語に内在する二面性を鮮やかに映し出しているということです。すなわち、形式的・構造的側面(ラング)と文脈的・個別的側面(パロール)の双方が、GPTの挙動にも対応物として認められます。

GPTの成功は、言語の形式面を極限まで掘り下げれば相当程度の「らしさ」や「意味らしさ」が得られることを示しました。同時に、GPTとの対比から浮かび上がるのは、人間の言語には統計的規則性だけでは説明しきれない余剰な何か(身体性や創造的意図、偶発性)が確実に存在するという点です。

生成AIの発達によって、かえって**「言語を使うとはどういうことか」「意味を理解するとは何か」**という根源的な問題が再提起されています。ソシュールの理論枠組みと先行研究の知見を援用しつつGPTを分析することは、単にAIの性能評価をするだけでなく、言語とは何か、人間らしさとは何かを再考する学術的契機となるでしょう。

生成AIを通じて言語の構造的側面の威力を再確認することで、人間の言語活動をより深く理解するヒントも得られます。今後の研究では、単なる技術論を超えて、生成AIと人間の言葉の本質に関するより包括的な議論が求められます。

コメント