導入:なぜTransformerに時間推論能力が必要なのか

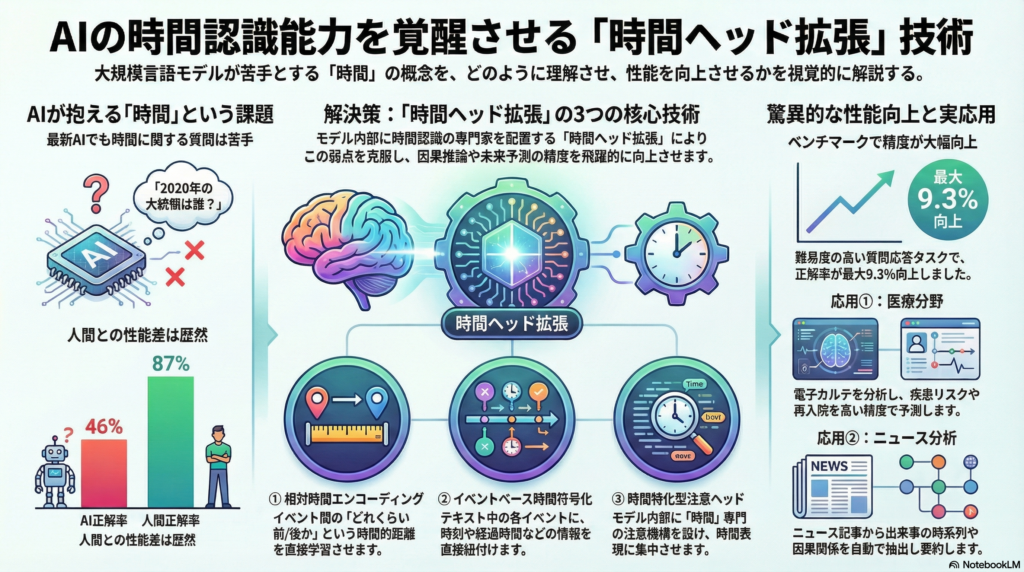

大規模言語モデル(LLM)の発展により、自然言語処理は飛躍的な進歩を遂げました。しかし、「2020年の大統領は誰だったか」「このイベントはいつ起きたか」といった時間に関する質問や、出来事の前後関係を問う推論タスクでは、最新のモデルでさえ人間の性能に大きく及ばないことが明らかになっています。

本記事では、Transformerモデルに時間概念を組み込む「時間ヘッド拡張」技術に焦点を当て、その設計手法、評価ベンチマーク、因果推論への効果、そして実応用までを包括的に解説します。

時間情報を捉えるための3つの核心技術

相対時間エンコーディング:トークン間の時間距離を学習

従来のTransformerでは、単語の順序を示す位置エンコーディングが用いられてきました。これに対し、相対的位置エンコーディングの手法では、トークン間の相対的な時間差や順序を直接エンコードします。

Shawらの研究を基盤とした**Temporal Relative Encoding(TRエンコーディング)**は、自己注意機構が時系列データ内のイベントの前後関係を捉えやすくする仕組みです。この手法により、モデルは「どのイベントがどれだけ前・後に起きたか」という距離情報を学習し、時間的順序推論の精度向上に寄与します。

イベントベース時間符号化:各イベントに時刻情報を紐付ける

テキスト中のイベントそのものに時間情報を付与する設計も重要なアプローチです。医療記録データに対するCEHR-BERTモデルでは、患者の年齢や診療時刻を表すベクトルを診断コードの埋め込みと統合しています。

このようなイベント時間の明示的エンコードにより、モデルが時系列データ内のイベント間隔や順序を理解しやすくなり、時間整合性の高い表現が得られるようになります。人工的な時間トークンを挿入し、各イベントの発生時刻や経過時間を表現する手法は、複雑な時系列パターンの学習に効果を発揮します。

時間特化型注意ヘッド:モデル内部に時間概念の専門家を配置

2025年の画期的な研究により、GPT系大規模言語モデルの内部に**時間概念に特化した注意ヘッド(Temporal Heads)**が存在することが判明しました。サーキット解析と呼ばれる手法でモデル内の情報流れを解析した結果、年号など時間を示すトークンに強く反応し、関連事実の想起に寄与する注意ヘッド群が特定されたのです。

この発見を踏まえ、モデル設計段階で時間ヘッドを拡張・付加するアプローチが考案されています。具体的には、Attention層の一部を時間情報に集中させ、時間表現(「〜年」「〜月」「〜後に」など)に高い重みを割くような機構です。

SAT-Transformerでは、Attention行列に時間的バイアスを与える学習可能カーネルを適用し、時間的に近いデータ点同士をより強く関連付けるよう促しています。この簡潔な拡張により、Transformerは短期的な時間依存の規則性を捉えやすくなり、長期依存も維持しつつ時間順序に一貫した注意を払えるようになります。

時間推論能力を測る3大ベンチマークデータセット

TimeQA:時間依存事実の質問応答

TimeQAは時間推論能力評価の代表的データセットとして広く活用されています。WikiDataから時間とともに変化する事実を抽出し、人手で検証した上で生成した質問応答対から成る約20,000件のデータセットです。

質問には「◯◯年には誰が〜だったか」のように特定年を問うものや、出来事の前後関係を尋ねるものが含まれ、モデルには時間的文脈の理解と推論が要求されます。長文QAモデルのベースラインであるFiDで正解率46%程度に留まり、人間の87%に大きく劣る性能が報告されており、この大きな性能差は従来モデルが時間に関する一貫した推論を苦手とすることを浮き彫りにしています。

TempReason:3段階の時間推論レベルを網羅

2023年に提案されたTempReasonは包括的ベンチマークとして注目を集めています。時間推論レベル別に3種類の質問を含むプロービングデータセットで、全体で52万件以上の多肢選択問題から構成されています。

- L1:時間-時間関係 – 時刻や期間の比較

- L2:時間-イベント関係 – イベントの発生時刻の推定

- L3:イベント-イベント関係 – 複数イベントの順序推論

各質問は出来事の順序関係や持続時間、頻度といった多様な時間的側面をカバーするよう設計されており、LLMの時間推論力を細かく評価できます。TRAM(Temporal Reasoning Ability Measurement)ベンチマークとも呼ばれるこの評価では、GPT-4でさえ人間より正答率で10%以上低いことが報告されています。

物語イベント・因果関係データセット

物語中のイベント順序や時間的一貫性を評価するデータセットも重要な役割を果たしています。Richer Event Description(RED)コーパスは物語中のイベント同士の「前後/同時」関係にアノテーションが付与されており、Transformerモデルを用いたイベント間の関係抽出タスクに利用されています。

また、2022年の**Causal News Corpus(CASE 2022)**は、ニュース文中に因果関係が述べられているかを判別するタスクが含まれており、時間推論を評価するデータセットはQA形式からイベント関係抽出まで多岐にわたっています。

因果推論精度を劇的に向上させる時間ヘッド拡張

時間順序の正確な把握が因果推論の鍵

時間情報の活用は因果推論にも直接的な影響を及ぼします。原因と結果の関係は時間軸に沿って展開するため、モデルが時間順序を適切に捉えることが因果推論の精度向上に繋がります。

ニュース記事中の因果関係抽出タスクでは、Transformerに時間認識能力を持たせることで時系列的な手がかり(「〜した後に…が起こった」等)を捉えやすくなり、因果関係の検出性能が向上します。CASE-2022ワークショップの因果イベント分類タスクでは、RoBERTaベースのモデル拡張により参加チームがトップ精度(1位)を達成しており、時間的文脈の統合が因果関係の判別を助けたと考えられます。

グローバルな時間整合性の確保

物語中のイベント因果推論では時間的一貫性の確保が重要です。単純なペアごとのイベント分類モデルでは、全体の時間グラフに矛盾(ループ状の因果など)が生じる問題がありました。

この課題に対し、Jinら(2023)はTransformerエンコーダで得たイベント表現をグラフニューラルネットワーク(GNN)で伝播させ、グローバルな時間順序制約を組み込む手法を提案しています。モデル内部で「全イベントの時間順序は埋め込み空間のベクトルのノルムで表現でき、時間順に並ぶほどある軸で単調な変化を持つ」という制約を設けることで、矛盾のない高品質なイベント時間グラフを構築することに成功しました。

時間知識グラフとの統合による推論強化

大規模言語モデルは文章中に明示された因果関係を再現することは得意でも、自ら新規の因果関係を発見・推論する力に乏しいという課題が指摘されています。

時間ヘッドの拡張や時間知識の統合は、この弱点を補う一助となります。**TimeKG(時間知識グラフ)**からの知識をLLMに与え、時間制約に合致しない回答にはペナルティを与えるようなTime-aware強化学習を行うと、モデルがストーリー中の因果矛盾を避け、時間的に尤もな推論を行う傾向が強まります。

数値で見る時間拡張モデルの性能向上

時間ヘッドや時間エンコーディングを拡張したモデルは、多くのタスクでベースラインを上回る性能を示しています。

時間QAタスクでの顕著な改善

時間情報埋め込みと強化学習を施したモデルは、TimeQAのハード版でExact Match(EM)が46%から約53%へ6.7%向上しました。この改善により、ベースラインのFLAN-T5やChatGPTを大きく凌駕する結果となっています。

TempReasonベンチマークでの大幅な精度向上

TempReasonベンチマークでは、特に難易度の高いL3(イベント対イベントQA)において、TempT5に対し提案モデルが以下の成果を達成しました:

- EM:21.1% → 24.9%(+3.8%)

- F1:32.4% → 35.8%(+3.4%)

L2(時間対イベントQA)では更に大きな改善が見られ、EMが84.8%から94.1%へ9.3%向上し、F1も88.9%から95.5%へ6.6%向上しています。

医療分野での実用的な成果

CEHR-BERTは電子カルテデータから学習し、入院・死亡・疾患予測のROC-AUCをすべて向上させました。特筆すべきは、5%の学習データでも従来モデルの100%学習を上回る効率的な学習が可能となった点です。これにより、データが限られる医療現場でも高精度な予測モデルの構築が現実的になりました。

知識グラフQAでの飛躍的改善

TimeR4フレームワークにより検索リライタと時制整合フィルタを組み込んだ結果、TKGQAタスクで約1.5倍前後の精度向上が報告されています。ベースライン比で+47.8%、+22.5%という相対的改善は、時間知識の統合が質問応答システムに与える影響の大きさを示しています。

実世界での応用:医療とニュース分析の最前線

臨床時系列データ分析への応用

時間拡張Transformerは医療分野で特に有用性を発揮しています。電子カルテ(EHR)には診療イベントが時系列で記録されており、患者の症状→検査→治療→転帰といった時間的因果チェーンの解析が重要です。

CEHR-BERTは何百万件もの患者記録から学習し、年齢や経過日数を埋め込むことで、時間経過に応じた疾患リスク予測を実現しました。心不全発症の予測や再入院予測タスクで従来のBERTベースモデルより高いAUCを達成し、時間情報を組み込むことの有効性が示されています。

SAT-Transformerのように、EHRタイムシリーズに短期依存バイアスを導入したモデルは、入院中患者の状態予測など複数の臨床タスクで既存最良モデルを上回る分類精度を報告しており、臨床決断支援や患者モニタリングにおいてより的確な予測と因果分析を可能にしています。

ニュース記事の時系列・因果分析

ジャーナリズムやソーシャルメディア分析でも、Transformerの時間推論能力が役立ちます。ニュースの出来事は時間とともに展開し、ある事件が後の事件に影響を与えるケースも多々あります。

時間知識を組み込んだモデルは、ニュース記事からイベントのタイムラインや因果系列を抽出するのに用いられています。大きな事件の経緯を自動要約する際、Transformerにより記事群からイベントを抽出し、時間順に整理して因果関係を紐付けることが可能です。

TimeKGを用いたQAでは「〜の後に起きた最初の出来事は何か」という問いに対し、モデルが知識グラフから該当期間の事実を検索し時間整合的な回答を返すことが可能となりました。CASE-2022のようにニューステキスト中の因果言及を分類するタスクでは、時間ヘッド拡張モデルが政策決定や市場変動などの記事間因果を自動分析する基盤技術として期待されています。

まとめ:時間推論能力の向上がもたらす未来

Transformerベースモデルへの時間ヘッド拡張は、抽象的な時間概念の理解と推論能力を高め、時間的順序推定、時間的因果推論、イベントの時間的一貫性評価といった複雑なタスクでベースラインを上回る成果を挙げています。

設計面では相対時間エンコーディングや時間特化注意機構の導入、学習面では時間知識に基づく強化学習やマルチタスク学習の工夫により、モデルは時間情報を明示的に保持・活用できるようになりました。TimeQAやTempReason、物語イベントデータやニュース因果コーパスといったベンチマークでの評価により、時間拡張技術の有効性が実証されています。

QAから物語理解、医療・ニュースまで幅広い領域で精度の向上と新たな知見の獲得が報告されており、時間は事実やイベントを語る上で不可欠の次元です。今後も時間対応型のTransformerモデルが各応用分野で重要な役割を果たすと期待されます。

コメント