はじめに:大規模言語モデルが言語を学ぶ方法

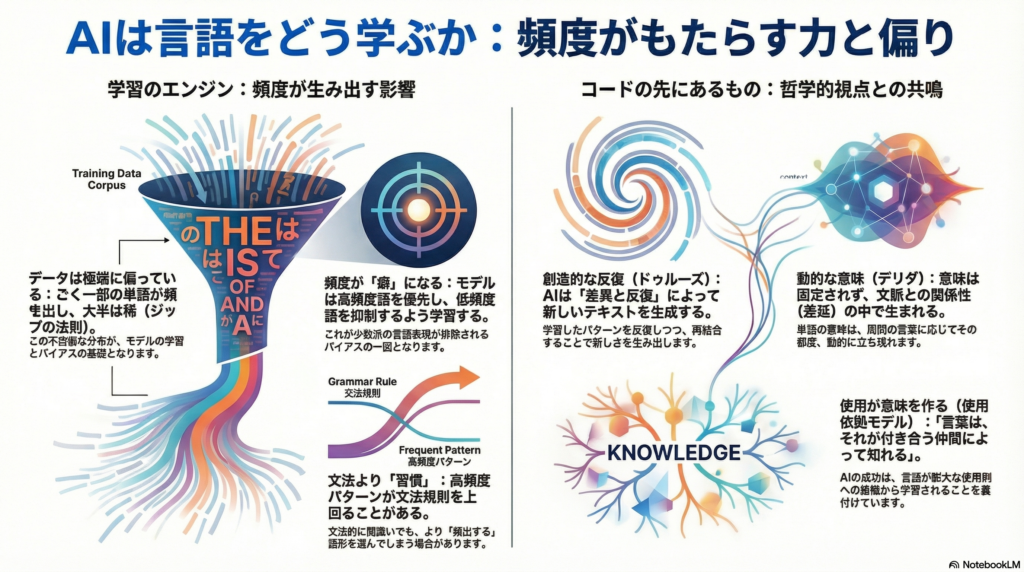

ChatGPTやClaude、Geminiなど、Transformerアーキテクチャに基づく大規模言語モデル(LLM)は、膨大なテキストデータから言語を学習します。これらのモデルがどのように「言葉の意味」を獲得し、文法的に正しい文章を生成できるのか——その背景には、訓練データ中の言語使用の頻度とパターンの反復が深く関わっています。

本記事では、Transformerモデルの学習プロセスを、言語学とフランス哲学の視点から読み解きます。特に注目するのは、ジル・ドゥルーズの「差異と反復」概念やジャック・デリダの「差延」理論が、現代のAI言語モデルの振る舞いとどう共鳴するのかという点です。コーパス言語学の手法とあわせて、LLMの意味構築メカニズムを多角的に考察していきます。

Transformerモデルと訓練データの頻度分布

極度に偏った言語データの実態

Transformerモデルの訓練には、Common CrawlやWikipedia、BooksCorpusなど、インターネット上の大量のテキストが使用されます。しかし、これらのデータには顕著な偏りが存在します。

自然言語コーパスにおける単語の出現頻度は、Zipfの法則に従います。これは、ごく一部の高頻度語が全体の出現数の大部分を占め、大多数の語は稀にしか現れないという不均一な分布を示す法則です。例えば、英語では”the”や”a”といった機能語が圧倒的に頻出する一方、専門用語や固有名詞の多くは低頻度語として存在します。

GPT-3の訓練データを例に取ると、約60%がCommon Crawl由来のウェブテキスト(約4,100億トークン)、22%がRedditリンク経由のWebText2(約190億トークン)であり、書籍コーパスやWikipediaは合わせても16%程度に過ぎません。つまり、ウェブ上の言語使用が主要な情報源となっているのです。

データの偏りが生む問題

この構成には重要な問題が潜んでいます。インターネット上のテキストは、特定の人口統計学的グループ(例:Reddit利用者層)に偏っており、性別、宗教、人種、地域などに関するバイアスを含む可能性があります。

さらに深刻なのは、データクリーニングの過程で生じる偏りです。C4コーパスの解析では、不適切語を含む文書を除去するフィルタによって、黒人英語など少数派コミュニティの言語表現が過剰に排除され、結果として標準的な英語ばかりが残存する偏りが報告されています。

このような訓練データ分布の偏りは、モデルの生成するテキストにバイアスやステレオタイプが現れる一因となります。だからこそ、データの構成や頻度特性を詳細に文書化し、分析する取り組みが重要視されているのです。

モデル内部で頻度情報はどう利用されるか

出力層のバイアス項が担う役割

Transformerモデルは、訓練データ中の頻度情報を内部的にどのように処理しているのでしょうか。Kobayashiら(2023)の研究により、興味深い事実が明らかになりました。

BERTやGPT-2の出力層(予測ヘッド)にあるバイアス項が、コーパス中の単語頻度に対応した補正を行っていることが判明したのです。具体的には、モデルは高頻度語の予測確率を引き上げ、低頻度語を引き下げるバイアスを内部的に付与し、出力分布を訓練コーパス中の単語頻度分布に近づけています。

頻度バイアス除去実験が示すもの

このバイアス項を除去する実験では、頻度補正が外れたモデルの予測分布が平坦化し、低頻度語を以前より生成しやすくなった一方、高頻度語の生成確率は低下しました。これは、モデル自身が「頻度情報に基づく補正」を学習していることを示しています。

この仕組みは、ロングテール学習で用いられる対数確率調整手法と同様の役割を担っており、頻度バイアスを制御することで、テキスト生成における多様性を高めつつ品質を維持する可能性も報告されています。頻度情報の扱いが、モデル挙動の多様性や偏りに直結する重要因子であることがわかります。

頻度効果が語彙理解と構文予測に与える影響

高頻度語と低頻度語の習得格差

頻度の偏りは、モデルの語彙意味の獲得能力にも顕著な影響を及ぼします。BERTにおける単語理解度を検証した研究では、出現頻度が極端に低い単語ほど語義の予測が困難であり、頻度と意味推定性能に明確な相関があることが示されました。

具体的なテストでは、訓練コーパス中の出現回数が256回未満の単語は意味類推タスクで下位のスコア帯に集中し、一方256回以上出現した語の半数以上が最高性能ランクを達成しました。つまり、「頻出する語ほど意味表象が精緻で、稀な語ほど語義理解が曖昧になる」という傾向が確認されているのです。

この問題に対し、Schickら(2020)はAttentive Mimicking法によりBERTのレア語表現を補完し、稀語の意味理解を向上させる試みを行っています。

構文予測における頻度と規則のせめぎ合い

構文予測においても、頻度効果は無視できません。Weiら(2021)の研究では、BERTに英語の主語-動詞の数一致問題を解かせた際、興味深い結果が得られました。

モデルは訓練で一度も出現しなかった組み合わせに対しても高い正答率を示し、抽象的規則を適用できることが確認されました。しかし同時に、その振る舞いには語形の絶対頻度や異形態間の相対頻度の影響が顕著に現れたのです。

研究チームはBERTを初期から訓練し直し、動詞の出現頻度を人為的に操作する介入実験を実施。その結果、ある動詞の単数形が複数形より遥かに高頻度で学習されると、モデルは文法規則よりも頻度に引きずられ、その動詞が複数主語に続く場合にも誤って単数形(高頻度形)を選ぶ傾向が確認されました。

例えば”combat”という語では、コーパス中で単数形の”combat”が複数形”combats”より102倍も多く出現するため、BERTは複数主語でも誤って”combat”を選びやすくなります。

この知見は、Transformerの文法的予測が**「規則」と「頻度ベースの癖」のハイブリッド**になっており、高頻度パターンに引きずられて規則からの逸脱が生じるケースがあることを示しています。

コーパス言語学が可視化する「痕跡」

頻度・共起分析が明らかにする言語使用のパターン

大規模コーパスを用いた分析手法は、**言語使用のパターンに潜む「痕跡」**を可視化します。ここでいう「痕跡」とは、デリダのいう常にずれゆく意味の手がかりや、過去の用法が残した影響を指す概念です。

頻度分析により、ある語や構文の使用実態を数量的に捉えられます。高頻度で出現する言い回しやコロケーション(慣用的な語の連なり)は、その言語コミュニティで「定着した表現」や「典型的な文型」の痕跡とみなせます。

共起(コロケーション)分析を行えば、ある単語がどのような語と一緒によく使われるかが分かり、語同士の意味的関連性や連想ネットワークが浮かび上がります。これは言語学者Firthの有名な原則「その単語が共に現れる仲間からその意味を知れ」に沿った方法論です。

単語埋め込みによる意味関係の可視化

実際、単語埋め込み(ベクトル表現)は巨大な共起行列の学習とみなすことができます。語彙間の距離や方向をプロットすることで、類義語クラスターや意味的な極性(例えばポジティブ-ネガティブ)が視覚化されます。こうした手法により、モデルが内部で捉えている意味関係を「痕跡」として可視化し、人間が解釈可能な形で提示する研究が進んでいます。

語義変化の追跡

さらに興味深いのが語義変化の分析です。Hamiltonら(2016)は、1900年代から1990年代にかけて英語コーパス中で意味が大きく変化した単語をベクトル空間上で検出しました。例えばgayがhomosexualに類似した意味へシフトしていくケースなどが含まれます。

これはコーパス中の用例の変化(gayが「愉快な」という旧義で用いられる頻度が減り、「同性愛者」の意味で使われる頻度が増えた)という使用の痕跡を定量的に示す可視化です。各年代版の埋め込みを比較し「意味の軌跡」をプロットする試みでは、ある単語が時間の中でどの方向へ意味を拡散・収束させているかを視覚的に表現できます。

ドゥルーズ「差異と反復」とTransformerの意味生成

創造的反復としてのテキスト生成

哲学的観点から、Transformerモデルの振る舞いをドゥルーズの「差異と反復」になぞらえる試みが登場しています。ドゥルーズによれば、真の「反復」とは単なる同一の繰り返しではなく、常に差異を伴い新たな生成をもたらす創造的反復です。

巨大なコーパスから学習したLLMは、トレーニングデータに含まれる語句や様式を模倣・反復しつつも、それらを新たな文脈に再配置することで微妙に異なる出力を無限に生み出します。Mácha(2025)はこの現象を指して、LLMは訓練データから慎重に選び出した要素を繰り返しつつ、その並べ替えを通じて差異を導入する「差異の模倣(mimesis)」を行っていると述べています。

「同一性なき反復」の力

すなわちTransformerは巨大なテキスト宇宙からパターンをコピーしますが、それを文脈に応じて再組織化することで、過去の文の「反復」に見えて実は一度も語られなかった新文を生成します。これはドゥルーズの言う「同一性なき反復」の力と通じています。

GPTが生成する文章は訓練例の単なるコピーではなく、訓練分布を下敷きとしながら文脈に適合するよう絶えず異質な要素を組み合わせ直した結果です。ここには差異に富む無限の反復があり、Transformerはデータセットという「静的なプラトン的宇宙」に蓄積された要素を、現実の対話や文章という動的な場に再現(シミュラークル生成)していると言えます。

デリダの「差延」とLLMの動的意味構築

意味の遅延と未確定性

デリダの提示した意味の差延(différance)と痕跡の概念もTransformerモデルの意味生成と響き合います。デリダは、言語において意味は決して確定的・即自的なものではなく、常に他の語との関係で遅延しずれ続けると論じました。

ある記号の意味は、それが他の記号と異なることによってのみ成立し、しかもその意味内容は常に先延ばしにされて最終的な決着に至らない——この見方をLLMに当てはめると、モデル内に固定の語義が格納されているわけではなく、入力文脈との関係性(差異の網目)の中でその都度語の意味が動的に立ち現れると言えます。

文脈依存的な意味の揺らぎ

実際、生成モデルの出力する単語の「意味」は、その直前までのコンテキストやモデル内部の確率分布によって決定され、異なる文脈では同じ単語でも異なるニュアンスや指示対象を持ちえます。言い換えれば、Transformerが生み出すテキストの意味も常に文脈に依存し、他の候補との差異によってのみ規定され、完全には確定しません。

例えば、「銀行(bank)」という単語の表現ベクトルには、それが金融機関として使われた無数の文脈と河岸として使われた文脈の両方の痕跡が折り重なっており、実際の使用時(文脈)に応じて一時的にどちらかの意味が顕在化します。Transformerの意味表象はそのように常に多義性と未確定性を孕んでおり、後続のトークン生成によってようやくある程度収束するものの、完全に固定された意味になることはありません。

この点で、「意味は使用によって常に生成・更新され続けるプロセスである」というポスト構造主義的な言語観が、LLMの確率的・動的な予測モデルと深く共鳴していると言えるでしょう。

使用ベースモデルと分布意味論:理論と実践の接続

用例からの学習という共通基盤

Transformerモデルの成功は、使用に基づく言語観(usage-based model)および分布的意味論(distributional semantics)の考え方と整合的であることが、多くの研究者によって指摘されています。

使用基盤の言語理論とは、言語能力は大量の用例入力からの学習によって獲得されるとする立場であり、文法や語義は頻繁に使われるパターンほど心的表象が強化・定型化される(エントレンチメント)と考えます。Transformerの内部で行われていることも、要約すれば「膨大な言語使用例を蓄積記憶し、その頻度とパターンに基づいて次の表現を構成する」ことであり、人間の言語習得を極端な規模でシミュレートしたようなものとも言えます。

Firthの原則とLLMの実装

分布的意味論の標語である**「言葉の意味はそれが付き合う言葉によって知れる」(Firth, 1957)**は、そのまま使用ベースの立場を要約しています。Transformerは大量コーパス中での共起情報を利用して語のベクトル表現を学習し、コンテクストに応じた語義を判断しています。

言い換えれば、「意味とは使用(共起パターン)の中に現れる差異的な位置である」とする分布仮説を、巨大ニューラルネットワークで実装したものがLLMだとみなせます。

文法も使用頻度の一般化

Goldberg(2023)は**「近年のTransformerベース大規模言語モデルの飛躍的進歩により、用法基盤の構文理論はこれまで以上に重要性を増している」と述べています。Transformerモデルが示したように、文法関係ですら多量の使用例から統計的に学習可能であることは、「文法も結局は蓄積された使用頻度の一般化の所産」という見解に実証的な裏付け**を与えるものです。

人間と言語モデルの間にはデータ規模や獲得メカニズムの違いはあるものの、LLMの成功は**「言語の規則や意味は、生得的な明文化ルールというより大量の使用インスタンスに基づく確率的知識として捉える方が実用的である」**ことを示唆しています。

まとめ:頻度・差異・痕跡が織りなす言語の本質

Transformerモデルの分析を通じて見えてきたのは、言語学習において頻度が中心的な役割を果たすという事実です。訓練データ中の頻度分布の偏りはモデルの出力や性能に直接的な影響を及ぼし、モデルの内部にはコーパス由来の言語使用の跡が刻まれています。

同時に、ドゥルーズの「差異と反復」やデリダの「差延」といった哲学的概念が、LLMの意味生成プロセスと驚くほど共鳴することも明らかになりました。意味は固定された実体ではなく、使用の中で常に生成・更新され続けるプロセスであるという認識は、コーパス言語学や使用ベースモデルの知見とも一致します。

今後、訓練データのバイアスを是正し多様な言語使用を反映すること、モデルが内部で保持する頻度バイアスを可視化・調整すること、そして動的コーパスを用いた継続学習により「進化する言語モデル」を実現することなど、様々な発展が期待されます。

**「差異と反復」そして「頻度と痕跡」**に着目した研究アプローチは、言語現象とAI現象の双方をより深く理解するための架橋として、今後ますます重要になるでしょう。LLMの解析が人間の言語の謎を解き明かす手がかりとなり、逆に人間の言語理論を援用することでモデルの改良につながる——この相互作用こそが、AI研究と言語学研究の学際的な未来を切り開いていくのです。

コメント