量子認知モデルと大規模言語モデルの融合が注目される理由

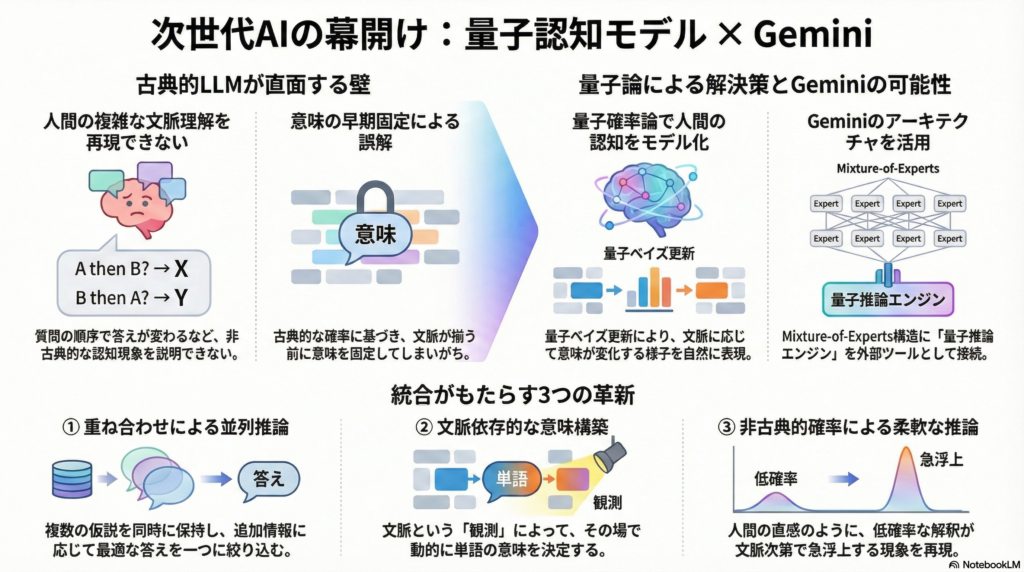

大規模言語モデル(LLM)は目覚ましい進化を遂げていますが、人間の文脈理解における「順序効果」や「文脈依存性」といった非古典的な現象を十分に説明できない課題を抱えています。従来のLLMはベイズ的推論を基盤としていますが、古典的確率論では捉えきれない人間の認知特性が数多く観測されています。

こうした背景から、量子確率論に基づく認知モデルとLLMを統合する研究が注目を集めています。量子力学の原理を取り入れることで、従来モデルでは説明困難だった文脈依存的な意味変化や非線形な推論プロセスを自然に表現できる可能性があるためです。特にGoogle DeepMindのGeminiのような最先端LLMは、その高い拡張性から量子的要素を組み込む土台として期待されています。

本記事では、量子ベイズ更新を核とする量子認知モデルとLLMの統合アーキテクチャについて、最新の研究動向と技術的可能性を包括的に解説します。

量子ベイズ更新を活用した言語生成モデルの最新研究

量子回路による生成モデルの表現力向上

量子力学の原理を取り入れた生成モデルの研究は近年大きな進展を見せています。Gaoらによる2022年の研究では、ベイズネットワークの量子拡張により表現力が向上することが実証されました。彼らが提案した「Bayesian Quantum Circuit (BQC)」は、n-gramモデルを量子回路で実装したもので、古典的モデルでは捉えにくい量子相関(絡み合いや文脈性)を利用して生成能力を高めています。

具体的には、n-gramモデルを行列積状態(MPS)で実装した「Basis-enhanced Bayesian Quantum Circuit (BBQC)」に拡張することで、古典的n-gramでは表現できない非局所的な確率分布を理論的に実現できることが証明されました。数値実験でも、テキストデータセットに対する尤度の向上が確認されており、量子手法が言語生成に資する可能性を示しています。

量子的ベイズ更新の特徴は、観測に伴う状態更新が量子測定の理論に基づいて行われる点にあります。旧来の信念状態が完全に破棄されず、測定結果とアドミクスチャ的に組み合わさる性質は、ディープラーニングにおけるスキップ結合にも通じる直観的な効果をもたらします。

隠れ量子マルコフモデル(HQMM)の可能性

Srinivasanらが2018年に提案した隠れ量子マルコフモデル(HQMM)は、連続的な確率分布を密度行列で保持するアプローチを示しました。彼らのヒルベルト空間埋め込みによるHQMM(HSE-HQMM)は、シーケンスモデリングで従来のLSTMや確率的状態空間モデルに匹敵する性能を示しており、ベイズ推論をヒルベルト空間上で拡張する有力な手法となっています。

HQMMでは量子的なベイズ更新(密度行列の更新)を繰り返すことで系列データをモデル化し、これを言語生成における次単語予測などに応用する試みも進められています。量子ベイズネット(QBN)も提案されており、人間のバイアス行動のモデル化で威力を発揮しています。

量子確率論とNLPの統合:QNLPの最前線

量子コンピュータ上での文意味解析

Quantum Natural Language Processing(QNLP)と呼ばれる研究分野では、主に二つの方向性があります。一つは量子計算プラットフォームを用いて言語処理を行う研究、もう一つは量子確率モデルを理論的枠組みとして言語現象を説明・モデル化する研究です。

前者の例としては、Coeckeらによる量子回路上での文意味解析(DisCoCatモデル)が知られています。また最近では、QLens(Quantum Lens)という手法が登場し、Transformerの各層をユニタリ作用素、中間表現を量子状態ベクトル、最終出力の確率をボルン規則で得るものとして再解釈する試みが進んでいます。これは物理学の視点でTransformerを理解する初歩的フレームワークとして注目されています。

量子認知学が解き明かす言語の文脈依存性

量子認知学の成果をNLPに応用する研究も進展しています。ヒルベルト空間上の状態ベクトルや非可換な射影測定を用いることで、人間の概念の組み合わせや文脈効果、意思決定のパラドックスを説明できることが示されています。

「ペット・フィッシュ問題」として知られる現象では、「ペット」と「フィッシュ」という概念を組み合わせると予想外のカテゴリ反応が生じます。Aertsらはこれが量子的文脈性(コンテキストに依存して意味が実現する非古典的相関)によって説明できることを実証しました。さらにBruzaらの研究では、人間が顔写真の印象を評価する実験でBellの不等式の違反が確認されており、意味解釈のプロセスそのものが量子的特性を持つ可能性が示唆されています。

興味深いことに、LLMを用いた実験でも文脈解釈においてCHSH不等式の体系的な違反が確認されており、人間と同様にLLM内部でも意味の文脈依存的な実現が起きている可能性が報告されています。

Geminiアーキテクチャへの量子統合の可能性

Mixture-of-Expertsと量子推論モジュールの連携

Google DeepMindのGeminiは、最新の大規模言語モデルファミリーとして、マルチモーダル対応や大規模コンテキスト処理など高度な機能を備えています。Gemini 1.5では新たにMixture-of-Experts(MoE)方式を組み込んだ革新的アーキテクチャが採用され、最大100万トークンという非常に長いコンテキストウィンドウを実現しました。

Geminiの内部は従来型のディープニューラルネットワークであり、現時点で量子状態や量子ゲートを直接扱うわけではありません。しかし、GeminiのMoE的なモジュール構造やツール使用インターフェースを活用し、量子的な推論モジュールを外部連携させる方法が考えられます。Gemini 2.0では外部ツールとして検索エンジンなどを統合しエージェント的行動を実現しており、この枠組みを拡張して「量子推論エンジン」をツールとして接続することが技術的に検討可能です。

長大コンテキストと量子的状態表現

Geminiの持つ長大なコンテクスト処理能力と高次元表現は、一種の大規模なヒルベルト空間埋め込みとみなすこともできます。重み空間で学習されたベクトル表現同士の内積は量子的な状態重ね合わせにも類似しており、LLM内部での注意機構は動的に文脈依存の関連性を計算する点で、量子モデルの「状態が文脈に応じて射影される」性質と対応づけることが可能です。

Geminiの自己注意層は文脈に応じて単語の意味ベクトルを更新しますが、この更新を量子的状態更新(測定とユニタリ変換の組合せ)として解釈する研究も進められています。したがって、Geminiそのものが量子的推論をネイティブに実装しているとは言えないまでも、そのアーキテクチャの柔軟性は量子的アイデアを組み込む土台になり得ると考えられます。

統合アーキテクチャがもたらす3つの革新

重ね合わせ状態による並列推論

量子モデルの導入により、LLMは重ね合わせ状態で複数の仮説を保持しながら推論を進めることができます。従来のLLMもビームサーチなどで複数候補を内部的に保持しますが、量子的アプローチではそれを原理的に並列表現し、干渉効果で非自明な候補の絞り込みを行える可能性があります。

質問応答シナリオで曖昧な質問に対し、量子的統合モデルは回答の候補をスーパーポジションに保持しつつ、追加の文脈情報に応じて一回の測定で答えを確定するといった振る舞いが期待できます。量子ベイズ更新により事後状態が適切に更新されるため、モデルは過去の情報も保持した一貫した推論を継続できます。

文脈依存的な意味構築の実現

量子モデルのコンテキスト依存性が真価を発揮するのが文脈理解です。量子セマンティクスの視点では、単語の意味は文脈という観測行為によって初めて定まるため、統合モデルでは文脈をヒルベルト空間上の演算として扱い、その場で意味を動的に構築することが可能になります。

多義語や曖昧な指示詞も量子的状態として保留し、十分な文脈が与えられた時点で一意に「観測」して解釈を確定する、といった柔軟な文脈理解が期待できます。これは古典的LLMが事前確率に基づき早期に意味を固定してしまうことによる誤解を減らす効果があると考えられます。

非古典的確率による柔軟な不確実性表現

統合アーキテクチャでは、確率は単なる頻度的・客観的なものではなく、観測行為やエージェントの関与によって変容する主観的なものとして扱われます。LLMが次の単語の確率分布を計算する場合、量子的枠組みではその確率が観測によってコヒーレントに変化し得ます。

技術的には、確率振幅の重ね合わせと干渉効果によって、ある解釈パスが他のパスを打ち消したり強めたりする挙動が現れます。これは、一見低確率の解釈が文脈次第で急に浮上するような、人間の直感に近い挙動を再現できる可能性があります。

量子的効果による言語生成の具体的メリット

量子的効果を取り入れることによる利点は、理論的・実践的両面で報告されています。

まず表現力の向上です。量子モデルは非局所的相関やコンテキストに依存した確率分布を表現でき、古典モデルに比べ表現力が高いことが理論的に証明されています。Gaoらの研究では、量子拡張したn-gramモデルが同サイズの古典モデルでは近似不可能な分布を生成できることを実データセット上で確認しています。

次に長距離依存の効果的なモデリングです。量子エンタングルメントに相当する機構を用いることで、文脈中の遠く離れた要素間の依存関係も自然に捉えることができます。量子モデルでは状態空間が指数的に豊かであるため、Geminiのような長大コンテキストでも情報を損なわず保持・相関付けできる理論的利点があります。

さらに人間の認知に近い振る舞いも期待できます。量子的確率はしばしば人間の直感的判断(文脈による突然の意味変化、質問順序で答えが変わる等)を再現します。統合モデルは、質問応答や対話生成でユーザの意図や感情といった観測行為を踏まえて応答内容を非線形に調整する振る舞いが可能になり、より一貫性がありつつ柔軟な対話を実現できるでしょう。

定量的には、HQMMなど量子的系列モデルがLSTMや他の深層学習モデルに匹敵する性能を既に示しています。SrinivasanらのHSE-HQMMは複数の系列データセットでLSTM並みの精度を達成しつつ、連続値特徴の分布推定という利点も示しました。

今後の課題と展望

量子モデルとLLMの統合には技術的課題も存在します。量子力学的な計算はノイズやデコヒーレンスの問題があり、現在のNLPタスク規模で直接量子計算を行うのは技術的ハードルが高いのが現状です。

しかし、量子インスパイア(古典計算機上で量子的手法を模倣する)なアプローチであれば、既存ハードウェアで実証研究を進めることができます。実際、本記事で紹介した多くの研究は古典シミュレーション上で量子的手法を検証したものです。

今後は、これらの知見を統合したプロトタイプ的アーキテクチャを設計し、小規模な言語生成タスク(限定的文脈での対話や質問応答など)で性能評価を行う段階へ進むことが望まれます。中長期的には、量子コンピュータの発展によりLLMの一部を量子ハードウェア上で実行することで、計算高速化や新しい生成能力が得られる可能性も視野に入ります。

量子認知モデルとLLMの融合は、人間の言語理解に迫る新たなAIへの一歩です。非古典的な確率論に基づくモデルは、単なる工学的性能向上だけでなく、人間の認知や意味理解のメカニズムをAIに組み込む試みでもあり、AIと認知科学の架橋として学際的な意義も大きいと言えるでしょう。

コメント