はじめに:なぜLLMに因果推論が必要なのか

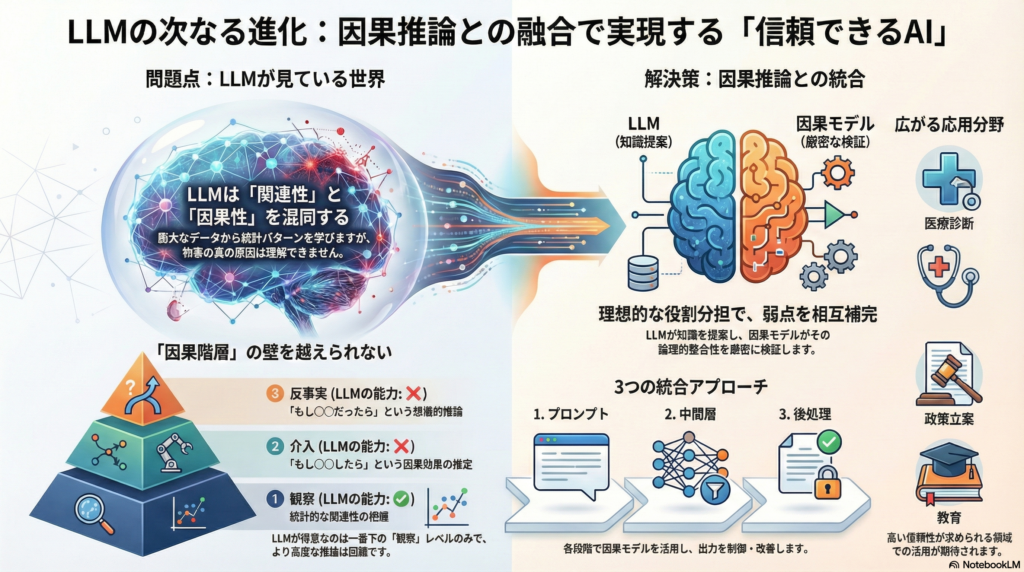

大規模言語モデル(LLM)は膨大なデータから統計的パターンを学習し、人間のような自然な文章を生成できるようになりました。しかし、LLMが学習しているのは主に「関連性」であり、真の「因果関係」ではありません。「ある事象の原因は何か」「ある介入を行えば結果はどう変わるか」といった因果的な問いに対して、LLMは訓練データ中に明示的な答えが存在しない限り、正確に推論できない可能性があります。

この制約を克服し、AIによる説明生成の信頼性と説明責任を高めるために、因果推論モデル(構造的因果モデルやグラフィカルモデル)をLLMに統合する研究が注目を集めています。本記事では、LLMと因果推論の統合による説明生成手法について、理論的枠組みから具体的手法、応用例、そして今後の課題まで包括的に解説します。

因果推論とLLM統合の理論的基盤

Pearlの因果階梯とLLMの限界

ジューディア・パールが提唱した因果の三層理論では、推論のレベルを以下のように分類しています:

- 観察レベル:統計的関連の把握

- 介入レベル:「もし〇〇したら」という因果効果の推定

- 反事実レベル:「もし〇〇だったなら」という想像的推論

深層学習モデルやLLMは第一層の関連推論には極めて強力ですが、第二層・第三層の因果的問いには直接答えられません。LLMは入力と出力のマッピングを学習しているに過ぎず、世界のメカニズムを表現するモデルが別途必要になります。

統合による新たな可能性

パールは「因果モデルこそが様々な因果質問に対してパースモニアス(簡潔)に答えを生成できる世界モデルである」と述べています。LLMの膨大な知識の網羅性と表現力に、因果モデルの介入可能性や反事実推論能力を組み合わせることで、より高度な説明生成が可能になると期待されています。

具体的な統合の枠組みとしては、LLMを因果推論エンジンのインタフェースとして用いるアーキテクチャが提案されています。例えば「Causal Reflection」フレームワークでは、構造的因果モデルに基づく推論結果をLLMが自然言語による説明や仮説として出力します。

LLMと因果モデル統合の既存研究

因果推論によるLLM出力の評価・改善

研究者たちは、LLMと構造的因果モデル(SCM)のハイブリッドシステムを開発しています。Gkountourasらの研究では、LLMと因果的なワールドモデルを組み合わせることで、複雑な推論や長期的な計画問題で純粋なLLMを上回る性能を示しました。

特に注目すべきは「CORE(Causal-driven Large Language Models)フレームワーク」です。この手法では、質問応答において以下のプロセスを実行します:

- LLMが初期回答を生成

- その根拠知識を因果グラフ上で変数として表現

- do-カルキュラスに基づく介入計算で因果効果を評価

- 因果効果が低い知識を排除し、回答を精査・修正

この手法により、ScienceQAやHotpotQAデータセットで説明の整合性と信頼性が大幅に向上したと報告されています。

計画立案における因果モデルの活用

「CausalPlan」フレームワークは、LLMが生成するプランの各候補を因果グラフでスコアリングし、再重み付けを行います。エージェントの行動履歴データから構造的因果アクションモデル(SCAモデル)を学習し、因果的に不整合なプランを排除または修正します。

マルチエージェント協調タスク(調理ゲームOvercooked-AI)での評価では、無意味な行動の大幅な減少と、エージェント同士の協調成功率の向上が確認されました。

因果関係を用いたLLM出力の制御・改善・検証

カウンターファクチュアル介入による出力制御

入力テキストへの介入を通じて、モデル出力に影響を与える要因を特定し制御する手法があります。具体的には、入力文中の特定の属性(性別、人種、数値など)を意図的に変更した反実仮想入力を作成し、元の入力と比較して出力の違いを観察します。

この方法により、入力のどの要素が出力に因果的寄与を持つかを分析でき、モデルが不必要なバイアスに依存していないか検証できます。

チェーン・オブ・ソートと因果的一貫性

「CaCo-CoT」と呼ばれるマルチエージェント推論フレームワークでは、複数のLLMエージェントに推論者と評価者の役割を与えて協調させます:

- 推論者エージェント:因果的な理由付けに基づく解答候補を生成

- 評価者エージェント:反事実的な問いかけで理由を検証

- 両者が協調して一貫した因果説明を導出

この対話的で協調的な因果推論により、単一のLLMが一度で出力する場合に比べ、矛盾が減り因果的整合性が向上します。

因果モデルによる出力の妥当性検証

LLMが生成した出力が既知の因果知識と矛盾していないか検証し、必要に応じて修正するポストプロセスも重要です。医療分野の診断説明生成では、LLMが出力した診断根拠を医学的因果知識ベースと突き合わせて検証し、矛盾があれば追加質問や説明の修正を行う仕組みが考案されています。

統合アプローチの分類:プロンプト・中間層・ポストプロセス

プロンプト生成段階での活用

LLMに与える入力プロンプト自体に因果情報を組み込むことで、モデル出力を因果的に誘導します。例えば医療診断の説明を求める場合、プロンプトに「症状Aには原因としてX、Yが考えられる。Xはさらにリスク要因Pを介して症状Aに影響する」といった因果知識を含めることで、LLMはその因果構造に即した説明を出力しやすくなります。

中間推論層での活用

LLMの思考プロセスに因果モデルを組み込み、逐次的な推論を因果的に整合させる方法です。CausalPlanはこのアプローチの代表例で、LLMエージェントがプランを生成する途中で因果モデルによる評価を挟み込み、各ステップで因果的一貫性を維持します。

出力ポストプロセスでの活用

一旦LLMが生成した出力に対し、後段で因果モデルを適用して評価・修正を行います。COREフレームワークはこの典型例で、LLMの回答をその根拠知識との因果関係グラフで評価し、不十分な点があれば回答を再生成します。

応用領域と具体的な課題

医療分野での活用

診断や治療方針の説明において、因果に基づく推論は不可欠です。LLMは電子カルテや医学文献から豊富な知識を引き出せますが、統計的関連に頼った誤った因果推論を述べる可能性があります。因果モデルを統合すれば、疾患の病因メカニズムや病態生理を表すモデルを活用し、医学知見に反する説明を排除できます。

課題としては、医学領域は因果知識が膨大かつ複雑であり、その構造をモデル化するコストが高い点が挙げられます。また説明責任が重大な分野ゆえに、専門家による慎重な検証とセットで運用する必要があります。

政策立案・社会科学への応用

政策介入がどのような結果をもたらすかを推論・説明する際、LLMは過去の類似事例や経済理論のパターンから回答を生成できます。ここに因果モデル(経済指標間の因果グラフや計量経済モデル)を組み合わせれば、政策効果のシミュレーションに基づき説明を裏付けることができます。

課題は、社会科学の因果モデルは不確実性や価値判断を伴うため、モデル出力をどう解釈するかという政策判断上の問題が残ることです。

教育・学習支援での可能性

LLMが生徒の質問に答える際、単なる回答提示だけでなく「なぜその答えになるのか」を説明させることが重要です。因果推論モデルの統合により、物理の問題で「なぜボールは坂を転がり落ちるのか」を説明する場合、力学的因果関係(重力→加速度→運動エネルギーの増加)のモデルを参照することで、より正確で概念的な説明を提供できます。

課題として、説明のわかりやすさも重要であり、因果モデルが複雑すぎるとかえって混乱を招く恐れがあります。生徒の理解度に合わせて抽象化レベルを調整する工夫が必要です。

科学的推論・研究支援における展開

科学分野では、仮説の生成や実験結果の解釈において因果推論が重要です。LLMが提案した仮説モデルをデータに基づき検定し、その結果をLLMが解釈・説明するというサイクルが可能になります。現状のLLMは科学論文から原因と結果を抽出する設問で限定的な成功しか収めていないため、科学ドメイン固有の知識グラフやシミュレーションモデルをLLMと統合する必要があります。

帰納的LLMと演繹的因果モデルの役割分担

LLMと因果推論モデルを効果的に統合するには、それぞれの得意領域を理解し適切に役割分担させることが重要です。

LLMの役割:知識の収集・提案

LLMは大規模データから帰納的・統計的パターンを学習しており、知識の網羅性や言語生成の流暢さに優れています。関連しそうな要因や過去の事例、ドメイン知識を引き出して因果モデル構築の材料を提供する役割を担います。

因果モデルの役割:検証と論理整合性の保証

因果モデルは人間が仮定を置いて構築した演繹的なフレームワークであり、介入や反事実の推論を厳密に行えます。LLMの提案を受けてデータや知識ベースからその因果関係の有無を検証し、本当に成り立つ因果かを判断します。

相互補完による高度な説明生成

因果モデルで確立された推論結果を、LLMが自然言語で解説し、背景や意味合いを付加してユーザに伝えます。LLMは知識を動員して例示やたとえ話を盛り込み、因果モデルの結果を物語的に説明することもできます。この役割分担により、網羅性と信頼性を兼ね備えた、ユーザフレンドリーな説明が実現します。

統合手法の限界と今後の研究課題

因果知識の獲得とスケーラビリティ

LLMは膨大なテキストから知識を獲得しますが、その中の因果知識は暗黙的で断片的です。統合システムでは因果モデルに明示的な知識を与える必要がありますが、網羅的な因果知識を自動で獲得するのは依然困難です。特に新規領域では因果モデル自体の構築がボトルネックとなります。

今後、知識グラフの自動構築やLLMからの知識蒸留を通じて因果モデルをスケールさせる研究が求められます。

モデル統合時の不確実性と矛盾

ハイブリッドシステムでは、LLMと因果モデルが矛盾する出力を示す場合があります。こうした矛盾をどう解決するかは難しい問題です。不確実性の表現が鍵となり、両者の出力には信頼度指標や前提条件を付与し、ユーザに最終判断を委ねる枠組みが考えられます。

汎用性と適応性の課題

現状の統合手法は特定のタスクでは有効性が示され始めていますが、汎用的に適用できるフレームワークは確立していません。各応用領域・タスクごとに適した統合方法やチューニングが異なります。将来的には、ドメインが変わっても使えるような統合アーキテクチャのテンプレートや、因果モデルとLLMを接続するミドルウェア的プラットフォームが求められます。

哲学的含意:説明責任・信頼性・因果的理解

因果モデルに基づく説明は従来のLLM出力よりも根拠が明確であり、モデルの判断過程を人間が追跡しやすくなります。これは社会的受容や法的責任を問う場面で重要です。

一方で、人間はもっともらしい因果説明を過大に信じてしまうバイアスを持つため、不適切な安心の問題にも注意が必要です。不確実性の表明や、必要に応じて人間が介入できるUI設計が対策として考えられます。

まとめ:AIの信頼性を高める次世代アプローチ

大規模言語モデルと因果推論モデルの統合による説明生成手法は、AIシステムに信頼性と説明力をもたらす有力な方向性です。理論的にはPearlの因果階層の上位にモデルを引き上げ、実践的には医療・政策・教育・科学など各分野での説明品質や決定の公正さを改善する可能性があります。

現状では技術的課題(知識獲得・統合設計・適応性)や哲学的課題(モデルの理解の本質・人間の安心感)も残されていますが、今後の研究開発を通じて、これらを克服し、人間社会に受け入れられる賢く責任あるAIを実現する上で、因果推論とLLMの統合は欠かせないテーマとなっていくでしょう。

コメント