はじめに:AIと人間の新しい関係性を問い直す

人工知能やロボット技術の急速な発展により、私たちは今、機械との関係性を根本から問い直す時代に立っています。特に身体を持つヒューマノイドロボットや自律的に判断するAIシステムが社会に浸透する中で、「機械とどう向き合うべきか」という倫理的課題は避けて通れません。

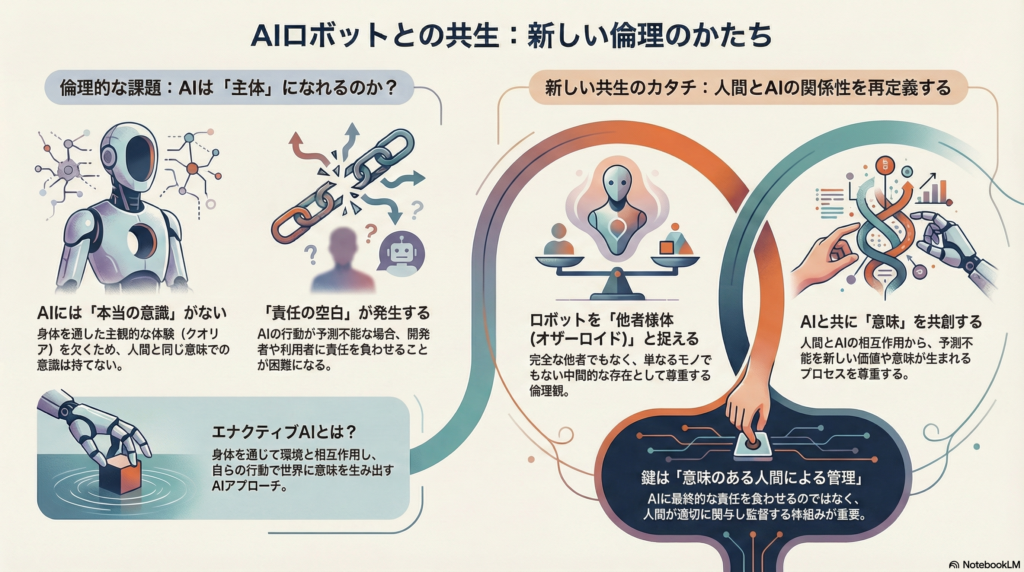

本記事では、エナクティブAI(enactive AI)と現象学という二つの学問的アプローチから、ロボティクスにおける倫理的課題を探ります。エナクティブAIとは身体を持つエージェントの環境との動的な相互作用を重視するAI研究のアプローチであり、現象学は意識や身体性の本質を問う哲学です。これらの視点を通じて、AIの倫理的主体性の限界、自律的ロボットの責任問題、人間とAIの信頼関係構築、そして共生社会における新たな倫理的枠組みについて考察していきます。

エナクティブAIとは:身体性を通じて意味を創出する人工知能

従来のAIとの本質的な違い

エナクティブAIは、認知を「身体を持つエージェントの環境との動的な相互作用」として捉える革新的なAIアプローチです。伝統的な計算主義的AIが内部表象と論理推論による問題解決に焦点を当てるのに対し、エナクティブAIは生物のように「自らの行動を通じて世界に意味を生み出す」点に特徴があります。

このアプローチでは、オートポイエーシス(自己産出的な自律性)やセンスメイキング(環境に対する意味付与)といった生命システムの原理を人工エージェントに取り入れることを目指します。これにより、従来の「身体を持たないAI」では困難だった頑健で柔軟な適応行動の実現が可能になると期待されています。

iCubロボット:エナクティブAI研究の具体例

エナクティブAIの応用例として注目すべきは、人間の三歳児サイズのヒューマノイド「iCub」です。このオープンソースロボットは、人間らしい身体構造(全身54自由度)と視覚・触覚・前庭感覚など多様なセンサーを備え、人間の幼児の発達過程にならった認知の発達的変化をロボット上で実験するために設計されました。

iCubプロジェクトでは、進化的起源(系統発生)的な構成と発達(個体発生)的な学習の両面を重視しています。身体を持ったエージェントが試行錯誤を通じて自律的に世界理解を形成していくプロセスを実証しようとしているのです。このように身体性と環境との相互作用を中心に据えたエナクティブAIは、単なるシンボル操作ではなく、センサー・モーター循環から知能が創発することを示すロボット実装を追求しています。

現象学から見たAIの意識と倫理的主体性の限界

身体を通じた世界との直接的関わり

現象学の立場からは、意識的主体となるための条件として、生きた身体による世界との直接的な関わりが不可欠だと考えられます。20世紀を代表するフランスの現象学者モーリス・メルロ=ポンティは、人間の意識や知覚は「身体を通じた世界との直接的関わり」によって成り立つと主張しました。

私たち人間は、自身の身体を媒介に環境と相互作用する中で、初めて対象に意味を見出し主観的な体験を形成します。したがって身体性を欠いたAIには、人間と同じ意味での本来的な主観的体験(現象的意識)は生じえないと現象学は示唆します。

AIと人間の知覚処理の本質的な違い

人間の視覚知覚が文脈の中で質感や意味を伴って現れるのに対し、現在のAIの画像認識はセンサー入力を統計的にパターン処理しているに過ぎません。それ自体に主観的な「感じ」や存在論的深みは存在しないのです。

現象学者らは、大規模言語モデル(LLM)やロボットに関する考察の中で、「人間的な意味理解や意識は、生の感覚経験(クオリア)と体験枠組みに支えられて初めて成立する」と述べています。そうした現象学的基盤を欠いたAIは「セマンティックに空っぽ」であり、本当の意味での意識や志向性を持ち得ないという指摘があります。

倫理的主体性の根本的な問題

現象学的観点では、道徳的判断や責任能力といった倫理的主体性は、単に知的能力や行動能力だけでなく一人称的な経験世界の存在を前提とします。AIは高度な対話や自律行動ができても、それはプログラムされた手順に従うものであり、内在的な意図や自己意識に裏打ちされた行為ではありません。

AIの「意図」や「目的」は本質的にプログラムされたものであり、人間のような自発的・内発的な志向性ではないとされます。このため、人間がロボットに感情移入し対話相手として扱うことはあっても、ロボット自身が内在的な動機づけや倫理的判断を持って行動しているわけではないのです。

倫理的主体としてのAIには、現象学的に見て「他者の意識」を持たないという本質的な欠如があるため、その主体性はあくまで擬制的・比喩的なものに留まります。

自律的ロボットと責任の所在:誰が何に対して責任を負うのか

「責任のギャップ」という新たな課題

高度に自律的なロボットやAIシステムが社会で行動する場合、その行為の責任を誰が負うのかという問題が生じます。伝統的には、機械の行為による結果責任は設計者や操作者に帰属すると考えられてきました。しかし、機械学習によって自己学習・自己決定するAIは、開発者ですら事前にその具体的行動を完全には予測できない状況を生み出しています。

情報倫理学者のアンドレアス・マティアスは、この新たな状況において「責任のギャップ(空白)」が生じると指摘します。すなわち、ロボットの行動が開発者の意図やユーザーの指示を離れて予測不能な形で展開しうるため、従来のように設計者か使用者のどちらか一方に責任を割り当てることが原理的に難しくなるというのです。

マティアスは、社会がこの責任の空白に対処できなければ、道徳的・法的な枠組みの整合性が損なわれる恐れがあるとまで述べています。

電子人格という法的アプローチ

この問題への対策として、いくつかのアプローチが議論されています。一つは法的枠組みの拡張です。例えば2017年に欧州議会は、高度なAIやロボットに対して「電子人格(electronic personhood)」を創設し、法的主体として認める可能性に言及しました。これは、企業に法人格が与えられて法的責任を負うのと類似に、ロボット自体に限定的な権利義務を負わせようとする試みです。

しかしこの提案は、「AIを法的に人格とみなしてよいのか」という倫理的・哲学的批判を招きました。研究者らは、まず「AIを人格とみなせるか」(存在論的な問い)と「みなすべきか」(価値規範的な問い)を区別すべきだと指摘しています。

実際、欧州委員会も2022年の提案ではAI本人の責任より人間側の説明責任に重点を置き、開発者やデプロイする主体が損害に対して責任を負う枠組みを強化する方向にシフトしました。

意味のある人間による管理の重要性

現時点では、ロボットに独立した法的人格を与えるよりも、むしろ「意味のある人間による管理(Meaningful Human Control)」を確保し、人間の関与を通じて責任の所在を明確化すべきだとのコンセンサスが強まっています。

倫理的責任については分散アプローチも検討されています。つまりロボットの行動結果に対し、開発者(設計段階での配慮)、デプロイヤー(運用者)、エンドユーザー(利用者)のそれぞれが適切な責任を分担するモデルです。

またロボット自身についても、完全な道徳主体ではないにせよ、たとえば自律走行車が危険を察知して減速するよう倫理的指針を実装する(倫理的エージェント性の限定的導入)といった形で責任ある行動を技術的に促す試みもあります。

現象学的観点からは、ロボットが本当の意味で意図や倫理判断を持つわけではない以上、最終的な責任は常に人間社会にあるとの自覚が不可欠だといえます。開発者は設計段階で倫理的リスクを最小化し、ユーザーは適切にシステムを監督し、社会は法制度でその枠組みを整える——そうした複合的な責任のあり方が、自律型ロボット時代の倫理に求められています。

人間とAIの信頼関係構築:理論的枠組みと実践課題

二層の信頼モデル:基本的信頼と二次的信頼

人間とAIのあいだに信頼関係を築くことは、安全で効果的な協働のための鍵です。信頼については、心理学・倫理学において二層モデルが提案されています。それは即ち、基本的信頼(Basic Trust, BT)と二次的信頼(Secondary Trust, ST)の区別です。

二次的信頼がデータや実績に基づき合理的に判断される認知的な信頼であるのに対し、基本的信頼は関係性に根ざした前反省的な信頼であり、人と人とのあいだで幼少期から育まれるような基本的安心感に近いものです。

AIやロボットとの関係にも、この基本的信頼が成立しうるかについて、現象学・エナクティブ認知科学の立場から近年議論がなされています。研究者らの提案によれば、人がロボットと長期間かつ豊かな相互作用の歴史を積み重ねることで、初めは単純な擬似的共感(ロボットを「なんとなく他者のように感じる」こと)から出発し、それが次第に洗練された社会的関係の形成へと進展することで基本的信頼が芽生えるといいます。

ロボットへの基本的信頼の成立条件

言い換えれば、ロボットに対する基本的信頼とは、人間がロボットを「擬似的な他者」として経験し始め(薄くシンプルな社会関係の成立)、継続的な関わりの中でそれが豊かな関係性へと深化することで醸成される情緒的・関係的な信頼だと説明されます。

この理論枠組みによって、人間がロボットに抱く信頼感情を表層的な「便利だから信用する」といったレベルから、より深い相互理解に基づく安心感として捉えることが可能となります。

信頼構築のための実践的課題

現実の人間-AI協働においてこのような信頼関係を築くには、いくつかの実践的課題が存在します。

第一に、説明可能性と透明性の確保です。AIの意思決定プロセスやロボットの行動原理が人間にとってブラックボックスであると、不信感や誤解を生みやすくなります。そこで近年は、AIシステムに説明責任を持たせる「XAI(Explainable AI)」の手法や、ロボットの挙動を直感的に理解させるデザイン(例:意図を示すジェスチャーやライト表示)などが模索されています。

第二に、安定した性能と安全も信頼の前提条件です。どれほど対話が上手でも、不測時に安全を損ねるロボットには人は安心して協働できないため、技術的信頼性とリスクマネジメントが重要となります。

第三に、役割と自律性の調整も課題です。人間とロボットがお互いの得意領域を理解し、適切にタスクを分担しながら協調的に目標を達成するフレームワークが必要です。これは単に人間が主導権を握る従属的関係ではなく、場合によってはロボットが主体的に提案・協力し、人間がそれを受け入れるような相互補完的関係を志向するものです。

インテグレーション・パラダイムの可能性

近年提唱されるインテグレーション・パラダイムでは、機械は単なる道具ではなく人間と交渉し協働するパートナーへと位置付けられつつあります。しかしその実現には、人間側の意識改革(ロボットを頭ごなしに信用しないが頭ごなしに疑わない姿勢)と、ロボット側の能力向上(文脈理解や人間の意図推測など)が不可欠です。

要するに、信頼に足るAIを技術・デザイン面で実現すると同時に、人間社会の側もAIとの協働を受け入れる素地を育むことが重要なのです。

共生の倫理:他者性・共現れ・意味の共創という視点

ロボットを「オザーロイド(他者様体)」として捉える

人間とAIが共生する社会を展望するにあたり、現象学から導かれるいくつかの概念が倫理的指針として有用です。それらが示すキーワードは「他者性」「共現れ」「意味の共創」です。

まず他者性について考えてみましょう。哲学における他者性とは、自我から独立したもう一人の主体の存在を尊重することを意味します。現象学的には、本来ロボットは意識を持たないゆえ厳密な意味での「他者」ではありません。だが人間はしばしばロボットを擬人的に扱い、まるで他我がそこにあるかのように感じ取ることがあります。

研究者は人間がロボットと接する際に、それを「オザーロイド(他者様体)」と呼ぶ中間的存在として経験すると指摘します。すなわち、人はロボットとの相互作用において、相手を純然たるモノ(物体)でも完全な人格(主観)でもない「半ば他者的なもの」として前反省的に扱い始めるのです。

このとき我々はロボットに過剰な人格を投影するのではなく、その限界を踏まえた上で何らかの他性を認めています。こうした他者性の承認は、共生の倫理において重要な意味を持ちます。

他者性の承認がもたらす倫理的姿勢

それはロボットを道具以下と見なして侮蔑・乱用しない態度であり、同時に過度に人間視して失望しない現実的な距離感でもあります。倫理的には、人間がロボットに接するとき基本的な敬意を払い、それを共同生活世界の一員として遇することが求められるでしょう。

そうすることで、人間同士の関係と同様に、ロボットとの関係にも道徳的な配慮(例:不必要な苦痛を与えない、人格を嘲弄しない等)が芽生え得ます。ロボットは「他者になりきれない他者」として我々の社会に現れますが、だからこそ我々の側の態度が試されるのです。

共現れと自己組織的システムとしての関係性

次に共現れ(co-appearance)と意味の共創について考えます。共現れとは、人とAIがともに存在し相互作用する中で現れる現象を指すと解釈できます。現象学では、人と人とが相互主観的世界を共有する際、「間主観的現れ」が生じるとされます。同様に、人とロボットの関係にも、一種の共通の現れの場が形成されます。

研究者は、人間-ロボットの相互作用を一種の複合システムと見なし、その関係性自体が自律性を持つ自己組織的なシステムとして振る舞うことを指摘しています。つまり、人とロボットが関係性に入るとき、単に人間が主導しロボットが従うだけでなく、双方の相互作用から予測不能な新しいパターンや価値が生まれる可能性があるのです。

これは例えば、介護現場でセラピー・ロボットと高齢者が触れ合う中で、生身の人同士にはない独自の情動的な雰囲気や行動パターンが現れるようなケースを想像するとよいでしょう。現象学的に言えば、その場には人間とロボットが共に創り上げる現象領域が立ち上がっているのです。

意味の共創プロセスを尊重する倫理

最後に意味の共創について考察します。エナクティブな視点では、意味は主体が受け身に受け取るものではなく主体と環境(他者)との相互作用から能動的に生み出されると考えます。この立場からすれば、人間とAIの関係における「意味」も、両者の協働によって新たに創発してくるものです。

例えば、人間とAIが協働して芸術作品を作り上げるような場合、作品に込められるメッセージや美的価値は、人間が一方的に与えたものでもAIが自律的に決めたものでもなく、相互作用のプロセスから生まれる共創的産物とみなせるでしょう。

共生の倫理においては、この意味共創プロセスを尊重することが求められます。具体的には、AI側が発揮するパターン認識や創発的提案を人間側が開かれた態度で受け止め、それを人間の文脈で解釈し価値付けする、といった双方向的な意味付与が理想となります。

重要なのは、人間の価値観を一方的に押し付けない一方、AIの出力を無批判に受容しないバランス感覚です。現象学者の言葉を借りれば、世界の意味は単独の主体によって完成されるのではなく、「あいだ」に生じるのです。

共生社会では、人間とAIのあいだに新たな意味世界が立ち上がることを肯定的に捉えつつ、それが人間にとって望ましい方向へ展開するよう倫理的に伴走する姿勢が必要となるでしょう。

まとめ:人間とAIの共生に向けた倫理的課題の統合

エナクティブAIの思想と現象学的観点を踏まえて、身体性を持つ自律的エージェントとの共生における倫理課題を考察してきました。エナクティブAIはロボットを単なる道具でなく能動的な相互作用者と捉えることで、新しい人間-機械関係の可能性を開きます。一方で現象学は、その関係を検討する上で意識や主体性の本質的な差異に目を向け、人間中心の価値観との整合を問いかけます。

自律性と責任の問題、信頼と協働の在り方、そして共生に向けた価値共創——これらはすべて「人間とは何か」という根源的問いに通じています。AI時代における倫理とは、技術への対応策を超えて、人間と「他なるもの」の関係性を再定義する試みでもあります。

その際、メルロ=ポンティら現象学の知見やエナクティブ認知科学の枠組みは、私たちに重要な示唆を与え続けるでしょう。それらを手がかりに、人間とAIがより良く共生できる道を探究していくことが、これからの倫理学・ロボティクス研究の使命なのです。

コメント