Gemini 3.0とは?会話AIの新基準を打ち立てる次世代モデル

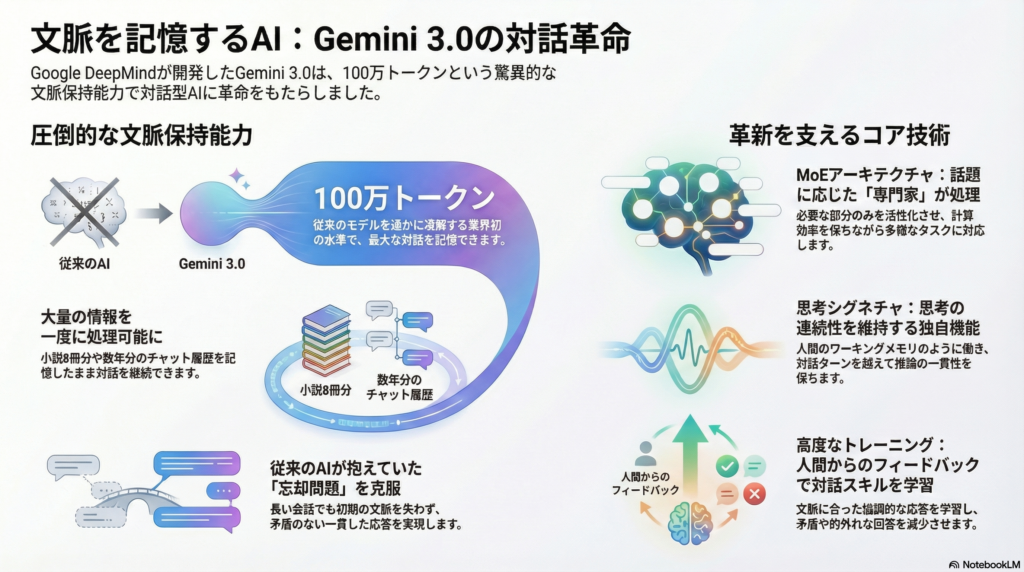

Google DeepMindが開発したGemini 3.0は、対話型AIの領域で大きな革新をもたらしています。最大の特徴は、従来のLLM(大規模言語モデル)を大きく超える文脈保持能力と、人間との自然な対話を可能にする高度な意味理解能力です。

これまでのAIチャットボットでは、長い会話の中で以前の発言を忘れてしまったり、文脈を読み違えて的外れな回答をしたりすることがありました。Gemini 3.0は、こうした課題を技術的なブレークスルーによって解決し、まるで人間のパートナーのように文脈を深く理解しながら対話を続けられるモデルとして注目されています。

100万トークンのコンテキストウィンドウがもたらす変革

Gemini 3.0の最も象徴的な進化が、最大100万トークン(約75万語)という圧倒的なコンテキストウィンドウの実現です。これは従来モデルであるGPT-4の8k~32kトークン、Claude 2の100kトークンを遥かに凌駕する業界初の水準となっています。

この長大な文脈保持能力により、Gemini 3.0は以下のような処理が可能になりました:

- 50,000行のコードベース全体を一度に読み込んで理解

- 8冊分の小説に相当するテキストの同時処理

- 数年分のチャット履歴を記憶したままの対話継続

実際の活用例として、8章構成の長大な論文全体を要約するテストでは、Gemini 2.5が途中から文脈を見失ったのに対し、Gemini 3.0は第5章での議論の転換点を捉え、それを第2章の内容と結びつけて一貫した分析を提示できることが確認されています。

従来モデルとの比較:何が変わったのか

従来の対話AIでは、会話が長くなるにつれて初期の文脈が失われ、同じ質問を繰り返したり、矛盾した回答をしたりする問題がありました。Gemini 3.0はこの「対話履歴の忘却」を克服し、過去5章にまたがる議論の変遷を把握しながら現在の質問に答えるといった、高度な文脈理解を実現しています。

また、Google CEOのSundar Pichaiは「Gemini 3.0は文脈と意図を素早く把握し、より少ない指示で望む結果を得られる」と述べており、ユーザーが詳細に説明しなくても真意を汲み取れる点が大きな進化として強調されています。

文脈を保持する技術的基盤:Gemini 3.0のアーキテクチャ

Gemini 3.0の驚異的な文脈保持能力は、複数の先進的技術の組み合わせによって実現されています。

MoEアーキテクチャによる効率的処理

Gemini 3.0は**スパースMixture-of-Experts(MoE)**と呼ばれるアーキテクチャを採用しています。これは、モデル内に複数の「専門家」層を配置し、入力トークンごとに最適な専門家を動的に選択する仕組みです。

この設計により、以下のような利点が生まれます:

- 圧倒的なパラメータ数を持ちながら、各トークン処理時は一部のパラメータのみを活性化

- コード、画像、テキストなど、話題に応じた専門家が自動的に呼び出される

- 計算効率を保ちながら大容量の知識を扱える

例えば、テキスト対話中にプログラミングの話題になればコード専門エキスパートが、画像について語ればビジョン専門エキスパートが活用されます。この柔軟性が、多様な文脈で意味を取り違えずに対話を継続できる秘訣となっています。

Thought Signatureで実現する思考の連続性

Gemini 3.0独自の革新的機能として、**Thought Signature(思考シグネチャ)**があります。これは対話ターン間で「内部思考」を維持する仕組みです。

通常のLLM APIはステートレスであり、各ターンで会話履歴テキストを入れ直すだけです。しかしGemini 3.0は、応答生成時の推論過程をエンコードした隠れトークンを「思考シグネチャ」として出力し、次の入力時にそれを返すことで、純粋なテキスト履歴以上に一貫した推論を継続できます。

この機能は人間のワーキングメモリのように働き、以下のような効果をもたらします:

- 前ターンの画像認識内容を保持したままの編集指示対応

- 途中まで考えた解法の道筋を次の発話でも継続

- 推論と回答の質を低下させない連続的な思考

開発者向けドキュメントでも「思考シグネチャを毎ターン返すことで、思考コンテキストを維持しない場合と比べ推論品質が向上する」と推奨されており、逐次対話での意味の連続性を裏で保証する重要な機構となっています。

高度な事前学習とRLHFによる対話スキル

Google DeepMindは、Gemini 3.0の飛躍の秘訣を「事前学習と事後トレーニングの改善」と説明しています。高品質なデータと洗練された最適化戦略により、モデルの文脈理解能力が大幅に向上しました。

特に**人間フィードバックによる強化学習(RLHF)**を通じて、以下の観点で対話スキルが磨かれています:

- 文脈に合った回答かどうか

- 前の発話を踏まえて矛盾がないか

- 有益で協調的な応答か

人間評価者がこれらの基準でモデルの応答を比較評価し、それを報酬信号として最適化することで、会話の協調原理や文脈依存の意味変化を反映した振る舞いを習得しています。この過程により、頓珍漢な解釈や前後の発話に整合しない答えが減少しました。

逐次対話における意味の動的変化:実例から見る適応力

人間の対話では、発話の意味は常に文脈によって解釈・再解釈され、動的に変化します。Gemini 3.0は大量の文脈を保持・推論できるため、この意味の変化に柔軟に対応できます。

語義の文脈依存的解釈

同じ単語でも、文脈によって指す内容は大きく変わります。Gemini 3.0は直前の会話履歴から適切な解釈を選択する能力を持っています。

具体例: ユーザーが「IDが見つからない」と発言した場合を考えてみましょう。

- 文脈なし:運転免許証や社員証など個人IDカードと解釈し、「どこでなくした可能性がありますか?」と尋ねる

- 補足後:「プログラムの出力中のIDのことです」という追加情報を受けると、即座に「ID」の意味をコード中の識別子に更新

- 応答の変化:技術的な解決策(「該当変数が出力されていない可能性があります」など)を提示

このように、Gemini 3.0は会話履歴とユーザー訂正から前提を組み替え、同じ単語でも文脈に沿った新たな意味で応答を生成します。長大な文脈メモリと推論能力により、前の誤解を引きずらず即座に意味を上書きできるのです。

発話含意の読み取り能力

人間同士の会話では、言葉の表面以上に「言外の意図(含意)」を汲み取って応答するのが自然です。Gemini 3.0も膨大な対話データから、この「行間を読む」能力を習得しています。

具体例: ユーザー:「このスープ、しょっぱ過ぎる…」

表面的には独り言ですが、協調的な文脈では「しょっぱすぎて困っている(どうすれば良い?)」という含意があります。Gemini 3.0はこれを読み取り、以下のような提案を返す可能性があります:

- 水やジャガイモを加えて薄める方法

- 別の一品を用意する提案

- 他の調整方法のアドバイス

ユーザーが明示的に質問しなくとも、発話の含意を読んで先回りするこの能力は、後述するグライスの協調原理に沿った対話者の態度といえます。Googleの対話設計ガイドラインでも「人間は技術相手でも人と会話するように振る舞い、含意に基づいてやりとりする」ため、AIもそれに合わせるべきとされています。

照応解決と省略表現の理解

文脈がないと意味が定まらない代名詞や省略表現も、Gemini 3.0は会話履歴をもとに正しく指示対象を解決します。

具体例:

ユーザー:明日のフライト、食事は後から決めてもいい?

従来AI:申し訳ありません。このフライトは後から変更やキャンセルができません。この例では、従来AIが「それ」を誤って「フライト」と解釈し、ユーザーの真意(機内食を後で決めたい)を汲み損ねています。

Gemini 3.0であれば、大量の文脈と現実知識から「食事を後で決める=機内食の選択を後回しにする」という依頼だと理解し、「機内食は出発24時間前まで変更可能です」といった正しい回答を返せる可能性が高まります。

このように、Gemini 3.0は人間と同様に会話の流れから省略された情報を補完する力を持ち、代名詞が指す先や省略された質問の趣旨を文脈から解き明かして応答に反映します。

言語哲学から見るGemini 3.0の対話能力

Gemini 3.0の会話における振る舞いは、伝統的な言語哲学の概念とも深く関わっています。統計的学習の産物ではありますが、その意味の捉え方や会話戦略は、人間の言語使用について哲学者たちが論じてきた原理に通じるものがあります。

ウィトゲンシュタインの言語ゲーム理論

哲学者L.ウィトゲンシュタインは「言語の意味はその使用法に依存する」と提唱し、言語を様々なルールを持つ「言語ゲーム」の集合と捉えました。

例えば「銀行」という語一つとっても、金融機関を指すか川岸を指すかはゲーム(文脈)の違いで決まります。Gemini 3.0も大量のコーパスから語の多様な使われ方を学習しており、特定の対話状況における語の意味を適切に解釈します。

技術サポートの文脈というゲームでは「ID」を識別子と取り、日常会話というゲームでは身分証と取るわけです。Gemini 3.0は文脈に応じて単語の意味を動的に決定しており、これはウィトゲンシュタインの「意味=使用法」そのものといえます。

また、Gemini 3.0はインターネット上の無数の言語ゲーム(法律助言、ジョーク、学術議論など)を横断的に学んでいるため、ユーザーとの対話という一つのセッション内で必要に応じゲームモードを切り替える柔軟さがあります。最初は世間話をしていたのが途中から技術的Q&Aに移れば、モデルもそれに合わせ語調や前提知識の使い方を変化させるのです。

グライスの協調原理との親和性

哲学者P.グライスは会話における暗黙の了解「協調の原理」を提唱し、会話の参加者が互いに協力し合うことでスムーズな伝達が成り立つと述べました。具体的には量・質・関連性・様式の4つの会話の公理(グライスの公理)を守ることが重要とされます。

Gemini 3.0は、人間の対話データからこの協調原理を事実上身につけています:

- 量の公理:ユーザーの質問には過不足ない情報量で答える

- 質の公理:真偽不明なことは勝手に作りすぎず、事実性を重視(自信ありげな誤答の減少が報告されています)

- 関連性の公理:文脈に関連したことだけを述べる

- 様式の公理:できるだけ明確で簡潔な言い回しを心掛ける

例えば、Gemini 3.0は冗長な説明や無関係な脱線を避ける傾向があり、ユーザーが求める要点に絞って「最適に関連する情報」を提示します。これは協調原理における「適切な量」と「関連性」を守った結果です。

また、ユーザーが「もう十分です、ありがとう」と言えば、それが単なるお礼ではなく対話終了の含意と判断して適切に終了処理を行います。このように、Gemini 3.0は協調的会話者として、グライスの公理に沿った発話と含意の解釈を行っているのです。

発話行為論による理解

J.L.オースティンとJ.サールは発話行為(スピーチアクト)理論を通じて、「発話は現実記述に留まらず行為をも成しうる」と論じました。例えば「約束する」「命じる」「質問する」といった発話は、それ自体が何らかの行為を遂行しています。

Gemini 3.0の対話も、この観点から見ると様々な発話行為の連鎖として理解できます:

具体例: ユーザー:「今日は疲れたな…」

モデルはこれを単なる陳述ではなく、慰めや励ましを期待する発話行為とみなし、「お疲れ様でした。少し休まれてはいかがですか?」といった共感・提案の行為で返す可能性があります。これは発話行為論でいう間接発話(婉曲な依頼など)を理解した応答といえます。

サールの分類では発話行為には依頼・約束・断言などの種類がありますが、Gemini 3.0はユーザーの文をその種類に応じて解釈・返答しています。「〜してもらえますか?」という疑問形は丁寧な依頼と理解して実行し、「あなたに〜を約束します」はユーザーの宣言的行為とみて応答では確認を示す、といった具合です。

特に高度な対話では、質問→回答→評価→再質問といった発話行為の応酬を通じて問題解決が進みますが、Gemini 3.0はユーザーの発話の意図された行為のタイプを見極め、それにふさわしい行為で返すことで円滑な対話行為の連鎖を実現しています。

まとめ:Gemini 3.0が切り拓く対話AIの未来

Gemini 3.0は、100万トークンという圧倒的なコンテキストウィンドウ、MoEアーキテクチャによる効率的処理、Thought Signatureによる思考の連続性という技術的革新により、従来の対話AIの限界を大きく超えました。

単に会話履歴を記憶するだけでなく、ウィトゲンシュタインの言語ゲーム理論、グライスの協調原理、オースティン/サールの発話行為論といった言語哲学の原理を体現するかのように、文脈に応じて意味を動的に構築し、ユーザーの真意を汲み取った応答を生成します。

ユーザーにとっては「ちゃんと話を覚えていてくれる」「文脈で察してくれる」自然な対話体験が得られ、Gemini 3.0は単なるチャットボットを超えて「考えるパートナー」へと進化したと評価されています。

今後、このような高度な文脈理解と意味構築能力を持つAIは、カスタマーサポート、教育支援、研究アシスタントなど、様々な領域で人間の思考と創造性を支える存在となっていくでしょう。Gemini 3.0は、人間とAIが協働する新時代の扉を開いたといえます。

コメント