はじめに:AIとの協働が人間の認知を変える

生成AIの普及により、私たちは日常的にAIと対話し、協働する時代を迎えています。しかし、AIを単なる効率化ツールとして捉えるだけでは、この関係性の本質を見誤る可能性があります。近年の研究は、人間とAIが長期にわたり協働することで、双方の知識形成プロセスそのものが変容していく「共進化」の様相を明らかにしつつあります。

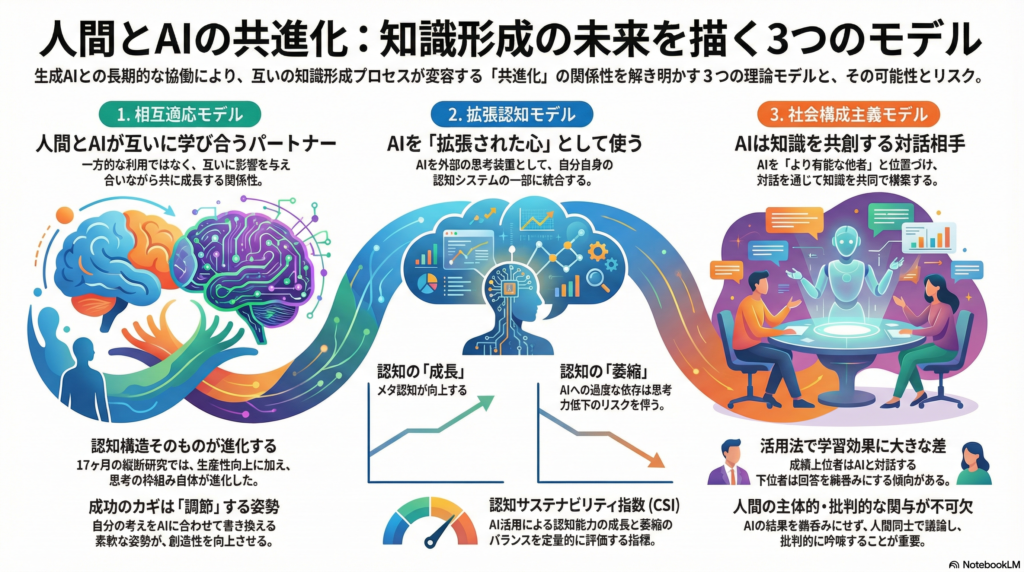

本記事では、人間-AI協働における知識形成を理論化した3つの主要モデル——相互適応モデル、拡張認知モデル、社会構成主義モデル——に焦点を当て、数か月から数年にわたる縦断研究の知見を整理します。これらの研究が示すのは、AIとの関わり方次第で、人間の学習スタイルや思考様式が劇的に進化する可能性がある一方、認知能力の低下というリスクも内包しているという複雑な現実です。

相互適応モデル:人間とAIが互いに学び合う関係性

共生知能としての人間-AI協働

相互適応モデルの核心は、人間とAIが一方的な利用関係ではなく、互いに影響を与え合いながら共に成長する「共適応」のプロセスにあります。Tong (2025)による60年分の研究レビューは、効果的な協働に至る因果メカニズムを「説明可能AI(XAI)による理解促進 → 相互適応 → 共有メンタルモデル形成」という連鎖で理論化しました。

興味深いのは、人間-AIチームのパフォーマンスには「課題によるパラドックス」が存在する点です。判断業務ではAI単独に劣る場合がある一方、創造的課題では相乗効果が現れることが確認されています。このパラドックスを解消するカギは、AIを外部ツールとしてではなく、人間の認知に内在化した「拡張自己」として統合することだと提案されています。

認知的適応力が協働の質を左右する

Wang & Chen (2024)は「人間-AI相互学習」という新たなパラダイムを提唱し、双方が知識を保存・交換・改良していく動的プロセスの重要性を強調しました。しかし、このような相互学習が実現するかどうかは、人間側の認知的取り組み方に大きく依存します。

Park (2026)による371名のプロフェッショナルを対象とした大規模フィールド実験では、ピアジェの同化・調節理論を援用し、AIとの協働効果を検証しました。結果は明確でした。既存の知識枠組みにAIを当てはめる「同化」戦略よりも、AIとの対話を通じて自分の認知スキーマを書き換える「調節」戦略を採る場合に、問題解決の質や創造性が有意に向上したのです。つまり、AIの潜在力を引き出すのは技術そのものではなく、ユーザの認知的柔軟性と内省的な関与姿勢だということです。

17か月の縦断研究が示す専門能力の劇的進化

相互適応の長期的影響を最も鮮明に示すのが、Hammer (2025)による17か月間の自己エスノグラフィー研究です。演劇教育者である著者自身がAIと継続的に協働した結果、以下のような変容が観察されました。

まず生産性面では、8か月間で85件のプロ水準の成果物を創出し、カリキュラム開発時間を80~90%短縮しました。さらに17か月後には218件の成果物に達し、アイデアをリアルタイムで記録・展開する能力が飛躍的に向上しています。

より注目すべきは認知面での変化です。協働を通じて、5つ以上の専門領域にわたる知見を統合する「分野横断的フレームワーク」を構築できるようになり、従来は両立困難だった創造性と効率性を同時に実現する「エコシステムレベルの認知アーキテクチャ」へと専門性が昇華したのです。

この事例は、人間とAIが長期間相互適応することで、単なるスキル向上を超えた「認知構造そのものの進化」が起こり得ることを示唆しています。

拡張認知モデル:AIを認知システムの一部として内在化する

人間-AIハイブリッド認知システムの形成

拡張認知モデルは、Clark & Chalmersの「拡張された心」理論に基づき、AIを人間の外部記憶や思考装置として機能する認知コンポーネントと捉えます。重要なのは、単なる作業の外注化ではなく、人間の認知体系自体がAIとの相互作用で再構成される点です。

Lou et al. (2025)の「Cognitio Emergens」フレームワークは、AIを「エピステミックな相棒」と位置づけ、人間とAIの構造的結合によって各々の認知が形作られていく過程を理論化しました。このモデルが批判するのは、短期的な効率評価や固定的役割観に陥りがちな従来研究の「時間的近視眼」です。真の共進化を理解するには、長期的ダイナミクスを捉える視点が不可欠だと主張しています。

認知の成長と萎縮のバランス管理

拡張認知には光と影があります。Kabashkin (2025)が提案した「認知的共進化モデル」は、AI導入による人間認知の二面性——成長(拡張)と萎縮(委ねによる低下)——を統一的に分析する枠組みを示しました。

このモデルでは、人間-AI相互作用を非線形システムとみなし、主体的・内省的な活用はメタ認知スキルを向上させる一方、過度の自動化依存は分析的自律性を損なう可能性があると定式化しています。両者のバランスを定量評価するため、「認知サステナビリティ指数(CSI)」が提案されました。

CSIは自律性・内省的関与・AI依存度など5つの行動指標から構成され、ソフトウェア開発者などのケーススタディでは、CSI値によって「認知的相乗ゾーン」と「認知萎縮ゾーン」を識別できることが示されています。この指標は、組織や教育機関がデジタルトランスフォーメーション戦略において、人間の認知能力を持続可能な範囲に保つための管理ツールとなり得ます。

思考の外在化と内在化の適切な役割分担

拡張認知モデルが投げかける本質的な問いは、「AIの活用によって何が認知的に拡張され、何が失われるのか」です。反復的なAI利用による認知的オフロード——考えるよりAIに聞く習慣——は短期効率を上げても、概念理解の深化を妨げる可能性があります。

この習慣が長期化すれば、人間の思考様式は徐々に再構成されていきます。AIで外在化できる部分と、人間が保持すべき内在的思考との適切な役割分担を動的に見極め、「認知の健康」を維持することが、拡張認知時代の重要課題となるでしょう。

社会構成主義モデル:対話を通じた知識の共創

AIを「より有能な他者」として位置づける

社会構成主義モデルでは、知識は社会的相互作用を通じて共同構築されるものと捉えます。Tran et al. (2025)は、ヴィゴツキーの「最近接発達領域(ZPD)」理論における「より有能な他者」の役割を、生成AIが担い得ると提案しました。

医学教育の文脈での考察ですが、大規模言語モデルは人間のZPDを拡張する仮想的対話相手となり、学習者に個別最適化された足場(スキャフォールディング)を提供できます。AI自身は意識や理解を持たなくとも、人間同士の議論を触発する媒介となることで、「共同的な知識構築」に寄与し得るのです。

ただし著者らは、このような協働学習の実現には慎重な教育デザインが必要であり、AIが学習の質を向上させるのか阻害するのかを見極めるため、既存の教育理論の再解釈が求められると警告しています。

成績上位者と下位者で異なるAI活用パターン

実証研究として注目されるのが、Fang & Zhou (2025)による258名の大学生を対象とした質的分析です。データ分析課題でChatGPTなどの生成AIを使用した学生の振り返りエッセイを分析した結果、成績上位者と下位者で顕著な違いが明らかになりました。

上位者はAIを協働的パートナーとみなして反復的にプロンプトを改良し、AI出力を批判的に評価しながら対話を通じた深い内省を行っていました。一方、下位者はAIの回答を無批判に受け入れるか全面的に拒絶するかの二極化した傾向を示し、反省的対話が不足していたのです。

この違いは、エピステミック・ビリーフ(知識観)の差に起因すると解釈されました。つまり、AIを「能動的な共学習者」と再定義し、振り返り支援やAIリテラシー教育を組み合わせることで、批判的思考力や分析力の深化につながる可能性が示唆されています。

学習コミュニティにおけるAIの役割

Li et al. (2024)は、大学生の協調学習グループに生成AIチャットボットを参加させる実験を行いました。結果、AIボット導入によりグループ内の発話役割(質問者、解説者など)が変化し、ピア間の知識共有プロセスに影響を与えることが示されました。

適切に設計すればAIは議論活性化役となり得ますが、放任すれば特定学生への発言集中など偏りも生じ得ます。このように「AIを学習共同体の一員」に見立てるアプローチによって、これまで人間同士で行われてきた社会的学習メカニズムがどう変容・維持されるかが、今後の重要な検証課題となっています。

人間の主体性と認知的自律性の確保

社会構成主義の視点から、Alami Ouahabi (2025)は生成AI時代における人間の認知的自律性の重要性を訴えています。知識が人間とAIの共同創造物になりつつある現在、AIに過度に依存すると個人の思考力や創造性が損なわれるリスク——受動的学習者化や社会的孤立——が懸念されます。

著者は、Nonakaの暗黙知-形式知モデルを下敷きに、責任ある知識共創のために「事前の内省 → 人間同士の協働 → AI結果の批判的吟味」という三段階プロセスを提案しています。これは前述の実証結果とも一致しており、AIと共創するにしても人間側の能動的学習姿勢と批判的思考が不可欠だという点を強調しています。

まとめ:共進化する関係性として人間-AI協働を捉え直す

本記事で紹介した縦断研究群は、人間とAIの協働関係を短期的な効率評価だけで判断することの限界を示しています。相互適応モデルは、双方が学習し合うことで新たな能力が共創される可能性を明らかにしました。拡張認知モデルは、AIを適切に認知に取り込むことで長期的相乗効果を得られる一方、考える責任を手放しすぎると認知力が蝕まれるリスクを警告しています。社会構成主義モデルからは、AIとの対話的知識構築を促進するには人間側の主体的・批判的関与が不可欠であり、教育デザインや組織文化がその成否を左右することが浮かび上がりました。

これらの知見が共通して指し示すのは、人間-AI協働を「共進化する関係性」と捉えることで初めて見えてくる課題と可能性があるということです。AI時代における人間の学習と知的成長の在り方は、今まさに再定義されつつあります。理論と実証を往還する精緻な研究の蓄積により、人間とAIが真に協働するパートナーとしてお互いを高め合う未来像が、より明確になっていくでしょう。

コメント