機能的情報量が注目される理由

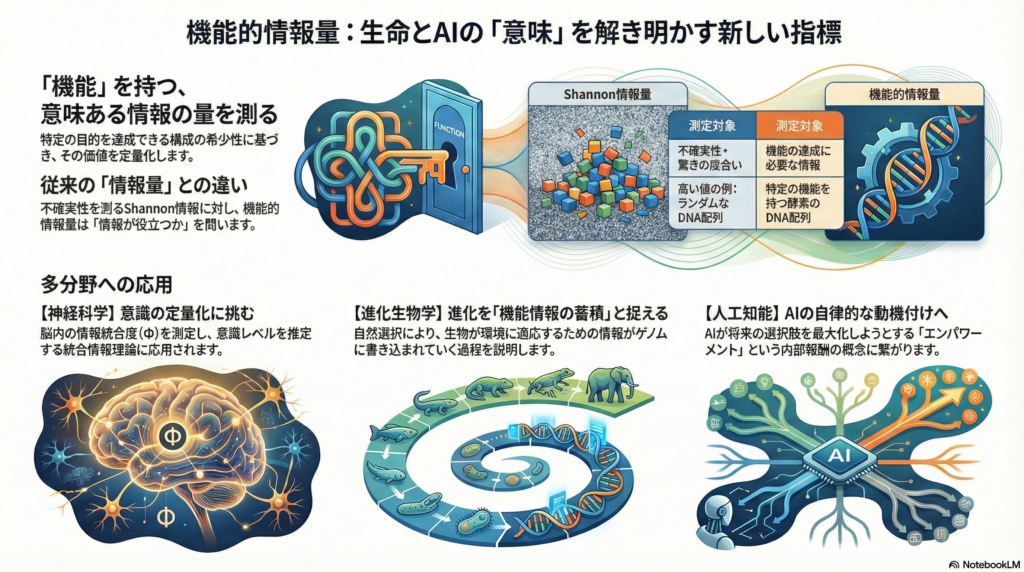

生命システムや人工知能の複雑さを測る上で、従来の情報理論だけでは捉えきれない側面があります。それは「情報が何のために使われているか」という機能的な観点です。機能的情報量は、単なる情報の量ではなく、特定の目的や機能を実現するために必要な情報を定量化する新しい概念として、生物学・神経科学・人工知能の各分野で注目を集めています。

本記事では、機能的情報量の基本的な定義から、神経系における応用事例、さらには進化や人工知能への応用可能性まで、幅広く解説します。

機能的情報量の基本概念:Shannon情報との違い

機能的情報量の定義

機能的情報量は、Hazenらによって提唱された概念で、生物や複雑系が特定の機能を達成するために必要な情報量を定量化します。具体的には、システムが取り得るすべての構成のうち、目標とする機能を満たす構成の割合に基づいて定義されます。

数式で表すと、I(Ex) = -log₂[F(Ex)] となります。ここで、F(Ex)は機能水準Exを達成できる構成の割合です。機能を実現できる構成がごくわずかであるほど、F(Ex)は小さくなり、結果として機能的情報量I(Ex)は大きくなります。

Shannon情報理論との本質的な違い

Shannon情報量(エントロピー)は、メッセージや状態の不確実性を測る指標であり、情報の「驚き度」を定量化します。一方、機能的情報量は「その情報が実際に機能を生み出すか」という観点を導入しています。

例えば、ランダムなDNA配列はShannon的には高い情報量を持ちますが、生物学的機能を持つとは限りません。逆に、酵素活性を持つDNA配列は全配列空間の中で極めて稀であり、その存在自体が重要な機能情報を担っていると考えられます。機能的情報量は、こうした「有意味な情報の量」をビット数で表現する枠組みなのです。

機能の定義と文脈依存性

機能的情報量を正確に議論するには、「機能」の定義を明確にする必要があります。対象システムによって機能の意味は異なります。

神経系では「刺激に対する行動応答」や「情報処理能力」が機能となり、遺伝子発現パターンでは「適切な時空間での遺伝子発現制御」が機能となります。重要なのは、「何をもってシステムが機能したとみなすか」を定義し、その達成度を定量化することです。

測定手法の多様性:理論から実験まで

古典的情報理論に基づくアプローチ

機能的情報量の測定には、Shannonの情報理論が基礎となる手法が広く用いられています。

エントロピー解析では、遺伝子発現の多様性や特異性を測定します。Schugらの研究では、複数組織における遺伝子発現プロファイルのエントロピーを計算することで、組織特異的遺伝子と汎用的遺伝子を区別しています。エントロピーが低いほど特定組織に特化した機能的遺伝子であることを示します。

発生生物学の分野では、Dubuisらがショウジョウバエ胚の位置情報を担う遺伝子発現の情報量を測定しました。その結果、ギャップ遺伝子は個々に約2ビットの情報を持ち、4つの遺伝子を組み合わせると各細胞の位置をほぼ一意に決定できることが示されています。

相互情報量は、入力と出力の間で伝達される情報量を測る指標として、シグナル伝達や神経応答の解析に活用されています。Cheongらの研究では、NF-κB経路などの分子経路が環境から細胞核への情報伝達能力として1ビット未満という低い値しか持たないことが報告されました。これは単一細胞がシグナルから得られる情報は限定的であり、細胞同士の協調が重要であることを示唆しています。

情報幾何学と表現空間の解析

情報幾何学は、Fisher情報行列によって定義される統計モデル空間の幾何学を用いて情報量を解析する手法です。神経科学では、ニューロン集団応答パターンの幾何構造が持つ意味が注目されています。

Kriegeskorte & Weiのレビューによれば、ニューロン集団応答の表現空間における配置が、Fisher情報や相互情報量、さらには行動性能に影響を与えることが示されています。表現空間で異なる刺激パターンがどれだけ分離されているかが、その情報を読み取って行動を変える上で決定的な要因となります。

部分情報分解:冗長性と相乗効果の定量化

複数の入力要因が関与する場合、単なる相互情報量では情報の重複(冗長性)や協調(相乗効果)を分解できません。部分情報分解(PID)は、この問題に対処するための枠組みです。

PIDでは、複数の入力が出力に与える総情報を、ユニーク情報(各入力だけから得られる部分)、冗長情報(両方から重複して得られる部分)、相乗情報(両方を合わせないと得られない部分)に分解します。

相乗効果は生物システムでよく見られます。神経科学ではマルチモーダル統合やニューロン間の協調発火によって、単独では符号化できない高次の特徴が表現されることがあります。遺伝ネットワークでも、複数の転写因子の組み合わせによって初めて発現が誘導される遺伝子が存在します。

最近の研究では、多ニューロン同時記録データに対してPID指標を近似計算し、視覚刺激に対して明確な相乗情報が検出されることが報告されています。

機械学習とシミュレーションの活用

複雑な生物データから情報量を正確に推定することは困難であり、近年では機械学習技術を活用したアプローチが増えています。ディープラーニングを用いて高次元データ間の相互情報量を推定する手法(MINEなど)が開発され、脳活動データや大規模発現データの情報解析に応用されています。

情報ボトルネック法は、入力データから出力に関連する情報だけを残して圧縮することで、必要十分な符号化情報量を求める手法です。Tishbyらの理論は神経科学にも影響を与え、感覚系が環境情報をできるだけ圧縮しつつ行動に必要な部分は保持するという符号化戦略の可能性を示唆しました。

人工生命プラットフォームAvidaでは、自己複製プログラム群を進化させ、論理演算タスクを解く能力を持つプログラムが出現する様子が観察されました。Hazenらの実験では、ランダムプログラムの大部分はタスクを実行できない一方で、ごく一部に高機能プログラムが存在し、機能的情報量が飛躍的に増大することが確認されています。

神経系における機能的情報量の応用

単一ニューロンから集団コードまで

神経系における機能的情報量の応用は、ニューロンの発火パターンが行動や認知という機能をどれほど支えているかを解析するアプローチとして発展しています。

感覚ニューロンレベルでは、刺激について運ぶ情報量が詳細に調べられてきました。ハエの視神経では、光刺激の動きに対して毎秒数十ビットの情報を伝達できることが示され、ニューロンが環境の変化を高効率に符号化していることが示唆されています。網膜神経節細胞では1スパイク当たり1~2ビット程度の情報を持つという測定結果があります。

このような定量化によって、神経系がノイズの中でどれだけ正確に情報を保持できているか、つまり神経コードの信頼性が評価できます。多くの感覚系でニューロンの符号化は効率限界近くに最適化されているという効率符号化仮説を支持する証拠の一つとなっています。

脳内ネットワークの情報フロー

脳内ネットワーク全体の観点では、相互情報量や情報フロー解析が機能的結合の定量化に用いられています。fMRIやEEG/MEGデータから脳領域間の情報的なやり取りを計測するために、転送エントロピーやGranger因果解析が使われ、一方向性の情報伝達を推定できます。

これらの指標により、脳が刺激処理中に情報をどの経路で流しているか、また意識下・意識喪失下で情報統合のパターンがどう変化するか、といった問題が研究されています。Casaliらは高密度EEGから統合情報量Φを推定する方法を開発し、健常者と無反応患者で脳内情報統合度合いが異なることを示しました。

統合情報理論と意識の定量化

脳における情報の統合と分散は、特に注目される研究領域です。Tononiらの統合情報理論(IIT)では、Φ(ファイ)と呼ばれる量でシステム内の統合された情報量を定義し、Φが高いシステムほど意識の水準が高いと仮定します。

Φはシステムをあらゆる分割に切り離した場合に失われる情報量として定義され、全体としては持っているがパーツごとに分けると消える情報量を測ります。これは高次の相乗情報量の一形態とも言えます。

IITによれば、人間の覚醒時の脳は非常に高いΦを持つ一方、深い麻酔下や睡眠時はΦが低下するとされています。統合情報量の枠組みから見ると、脳が高度に機能するためには部分ではなく全体として持つ情報パターンが重要であり、それを定量化することが脳理解に不可欠だという視座を提供しています。

神経集団の冗長性と相乗性

多ニューロン同時計測データでは、異なるニューロンが同じ刺激特徴を符号化しているケース(冗長性)や、組み合わせで初めて表れる特徴を符号化しているケース(相乗性)の両方があります。前者は信頼性向上やノイズ低減の機能を持ち、後者は新たな情報統合の役割を担います。

部分情報分解の手法を用いて、これらを定量的に切り分ける研究が進んでいます。視覚刺激に対するサル視覚野ニューロン群の発火に対してPID指標を近似計算した研究では、刺激によっては明確な相乗情報が検出されることが報告されています。

進化と人工知能への応用可能性

進化における機能情報の蓄積

進化の文脈では、自然選択によって生物が環境に適応していく過程を「機能情報の蓄積」として捉えることができます。生命の進化に伴い、生物システムは新たな機能を獲得し、それに対応する情報がゲノムに書き込まれていきます。

原始的な生命から複雑な多細胞生物への進化は、多数の新たな機能の獲得と軌を一にしています。これら機能獲得はゲノム中のDNA配列にコード化されていると考えられ、ゲノムは進化を通じて世界について蓄積された情報のリポジトリであるとする見方もあります。

Hazenらは、RNAアプタマーを例に、進化や実験選択によって機能的配列が富集される様子を考察しています。全てのランダムRNA配列中で特定分子に強く結合できるものはごく一部ですが、試験管内進化により結合能の高い配列が選抜されていくと、その集団全体の機能的情報量は飛躍的に上昇します。

Lenskiらの研究では、Avida上で進化するデジタル生物が世代を追うごとに論理演算タスクを次々と獲得し、ゲノム長あたりの情報量が増加していくことが報告されました。この研究は、機能的複雑性がダーウィン進化の過程で自然に増大し得ることを示す定量的な証拠となっています。

エンパワーメント:人工知能の内発的動機づけ

人工知能分野では、生物が持つ情報処理戦略を取り入れることで、より適応的・自律的なエージェントを作る試みが進んでいます。その一つがエンパワーメントという概念です。

エンパワーメントは、エージェントの取りうる行動とそれによって到達し得る将来の状態との相互情報量の最大値として定義されます。これは環境に対する制御力の定量化と解釈でき、行動の選択肢が結果に大きな影響を与えられるほどエンパワーメント値は高くなります。

Klyubinらが提唱したこの概念は、タスク非依存の汎用的な内部報酬として注目され、エージェントが環境内で将来の自由度を最大化するよう行動を学習するための指針となります。強化学習でエンパワーメントを報酬に組み込むと、エージェントが積極的に環境を探索し、未知のタスクにも柔軟に対処できる自律性が向上するとの報告があります。

情報ボトルネックと学習の最適化

ディープラーニングでは、情報ボトルネックの考え方をネットワーク可視化に応用し、学習の各エポックで中間層が入力情報をどれだけ圧縮しつつ出力ラベルに関する情報を保持しているかを解析する試みがあります。

Tishbyらの手法によれば、学習初期には中間層は入力の多くを保持していますが、学習が進むと出力に不要な情報を捨てて必要な情報のみをエンコードするようになります。これは人間の脳が成長につれて不要なシナプスを刈り込んで効率的回路を残すプロセスに例えることができます。

AIの学習過程を情報量で解析することで、知能獲得と情報表現の関係が見えてくる可能性があります。

理論的含意と今後の展望

意味のある情報の科学的扱い

機能的情報量の研究は、「意味のある情報」を科学的に扱おうとする流れの一部です。従来、情報理論は意味を排除して定量化することを旨としてきましたが、生物やAIを議論する上で「何に役立つ情報か」を無視できないとの認識が高まっています。

Kolchinsky & Wolpertなどは「意味的情報」の定義を提案し、あるエージェントの目的関数に貢献する情報こそが意味を持つ情報だとしました。これは機能的情報量と非常に近い考え方であり、環境中の事象についての情報のうち、エージェントの将来の成功率を上げるのに寄与する部分を抽出し測定しようというものです。

計算理論と複雑系科学への貢献

機能的情報量を厳密に定義・計算する試みを通じて、計算理論や複雑系科学へのフィードバックも生まれています。Kudelićは機能的情報量の一般定量法を提示し、計算複雑性理論の枠組みでそれを扱う最初のステップを示しました。

機能的情報量が極端に大きい(解空間で非常に稀)ならば、その機能獲得は計算的にも困難であることを意味します。このことは進化過程の計算困難性や、人工知能がある問題を習得する難しさとも関係します。情報と計算量のトレードオフは今後の理論研究の興味深いテーマとなるでしょう。

学際的架橋としての期待

機能的情報量の概念は学際的な架橋として期待されています。物理学では情報とエネルギー・物質の深い関係が議論されてきました。生命は局所的にエントロピーを下げつつ機能を生み出す存在であり、これを情報論的に見ると「環境から取得した情報を使ってエントロピーに抗い秩序を維持している」とも言えます。

近年では熱力学的な情報量についての研究も進み、Maxwellの悪魔の問題などと絡めて議論が活性化しています。その中で、生物が何のために情報を使っているかを考慮する必要があり、機能的情報量がその指標となり得ます。

まとめ

機能的情報量は、生物や複雑系が特定の機能を果たすために必要な情報を定量化する新しい概念です。従来のShannon情報理論が情報の不確実性を測るのに対し、機能的情報量は「その情報が実際に機能を生むか」という観点を導入しています。

神経科学では、ニューロンの発火パターンが行動や認知をどれほど支えているかを解析する手法として応用され、脳内の情報統合や意識の定量化にも貢献しています。進化生物学では、自然選択による機能情報の蓄積過程として進化を捉える視座を提供し、人工知能分野では内発的動機づけや学習の最適化に活用されています。

今後の研究では、実験的に機能的情報量を測る技術の開発、機能的情報量と進化速度の関係解析、AIにおける効果的な情報指標の発見などが期待されます。生物と人工物を貫く情報と機能の統一的理解が深まることで、新しい科学パラダイムが築かれる可能性があります。

コメント