はじめに:なぜAIに記憶と共感が必要なのか

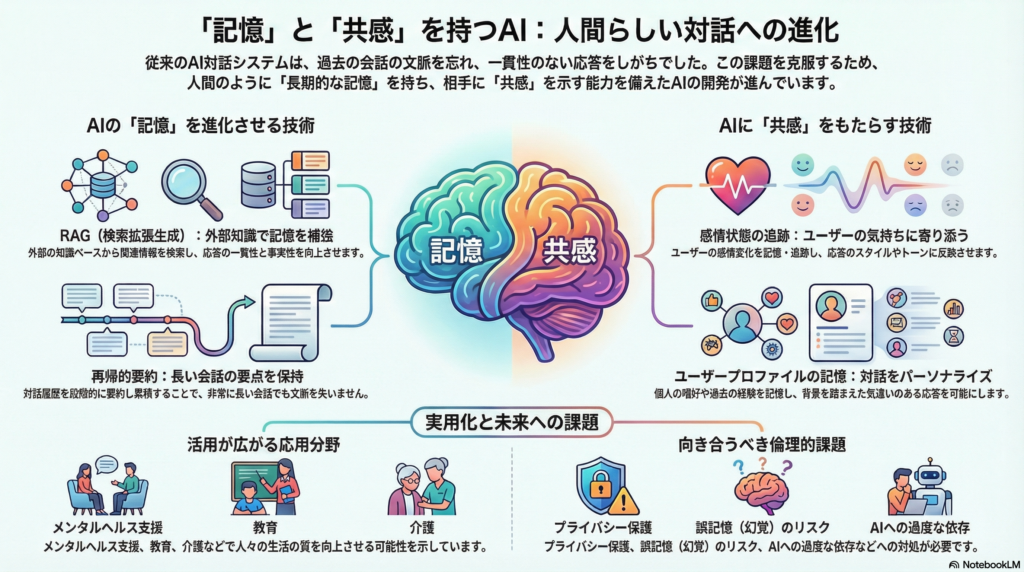

人間との自然な対話を実現するために、AI対話システムには2つの重要な能力が求められています。それは長期的なコンテキスト記憶と共感的一貫性です。

私たちが友人や家族と会話するとき、相手の過去の発言や感情状態を自然と記憶し、それを踏まえて応答します。しかし従来のAIシステムでは、会話の文脈が長くなるほど過去の情報を失い、一貫性のない応答をしてしまう課題がありました。

本記事では、こうした課題を解決する最新のAI技術、評価手法、実用化事例、そして今後の展望について、学術研究を基に詳しく解説します。

長期記憶を実現するAI技術の進化

メモリ拡張型ニューラルネットワークの登場

AIに長期記憶能力を持たせるため、ニューラルネットワークに外部メモリを統合する手法が古くから研究されてきました。代表的なものとして、Neural Turing Machine(NTM)やMemory Networksがあります。これらは時系列データ中の長期的な依存関係を捉えることを目的としています。

近年では、Transformerアーキテクチャにメモリ機構を組み込んだMemformerやNeural Attention Memory(NAM)といった新しいモデルも提案されています。これらは一度きりの経験から学習するワンショット学習を可能にし、より柔軟な記憶と想起を実現します。

RAG:検索で知識を補完する仕組み

大規模言語モデル(LLM)には文脈長の限界があります。この問題に対処するため、**Retrieval-Augmented Generation(RAG)**という手法が注目されています。

RAGは外部の知識ベースから関連情報を検索し、応答生成時にその情報を活用します。Facebook AIが提唱したこの手法により、応答の一貫性と事実性が大幅に向上しました。ただし、膨大な対話履歴から必要な情報を正確に取得することや、検索システム自体の精度向上が今後の課題となっています。

LangChainのメモリアーキテクチャ

実装フレームワークの観点では、LangChainが提供するメモリ機構が実用的です。LangChainでは以下の2種類のメモリを区別しています:

- 短期メモリ(スレッドメモリ):現在の会話内の発話を保持。長い対話では古い履歴を要約・削減してコンテキストウィンドウの制約を回避

- 長期メモリ:複数セッションにまたがるユーザープロファイルや知識を永続化。別の会話でも参照可能

長期メモリは、セマンティックメモリ(事実)、エピソード記憶(過去の出来事)、手続き記憶(方針やルール)といった種類ごとに情報を保存し、必要に応じて検索・利用できます。

ChatGPTにおける長期対話の工夫

ChatGPTを含むGPT系モデルは数千〜数万トークンのコンテキストを保持できますが、それでも長期対話では過去情報の欠落や応答の不整合が生じます。

この問題に対し、Wangら(2023)は再帰的要約手法を提案しました。小さな対話履歴ごとに要約(メモリ)を生成し累積することで、非常に長い会話でも最新の要約を参照して一貫した応答を得られます。

また、Shinwariら(2023)の研究では、関連度に基づいてメモリをプルーニング(削減)し、重要度の高い過去発話のみを保持することで、メモリ使用量を抑えつつ文脈的整合性を改善しています。

共感的対話を実現する技術

感情状態のトラッキング

共感的な応答を一貫して行うには、AIがユーザーの感情変化を記憶・追跡し、応答スタイルに反映させる必要があります。

Zhouら(2018)が開発した**Emotional Chatting Machine(ECM)**は、内部感情状態ベクトルを用意し、ユーザーの感情に寄り添った応答を生成します。ECMでは以下の3つの機構を組み込んでいます:

- 感情カテゴリ埋め込みによる高位表現

- 内部感情状態の動的更新

- 外部感情メモリ(感情表現用の語彙リスト)

これにより、文法性と内容を損なわずに感情表現を調整でき、従来のSeq2Seqモデルより高い共感スコアを達成しました。

ユーザープロファイルの記憶

ユーザーごとの個人情報、嗜好、過去エピソードを保存することで、よりパーソナライズされた共感を示すことができます。

例えば、AIがユーザーの以前の発言から「家族を失って落ち込んでいる」「就職活動で悩んでいる」といった情報を記憶していれば、その背景を踏まえた気遣い発言が可能になります。

教育分野の研究では、ロボット家庭教師が学生ごとの学習履歴や感情反応を長期記憶し、それに応じてフィードバックを変えることで、生徒の学習意欲と成果が向上したという報告があります。このシステムでは、人間の記憶に基づく適応を模倣するため、感情知能モジュールと長期メモリを組み込み、学生の過去の挫折や成功体験を踏まえて励まし方を調整しています。

対話履歴の重み付けと要約

長い対話履歴から重要な部分を抽出して保持し、不必要な詳細は忘れる戦略も重要です。

直近の発話や強い感情表現を含む発話に高い重みを与え、時間経過とともに古い情報の重要度を下げるアルゴリズムが用いられます。Wangらの再帰的要約では、一定ターンごとに履歴を要約し直すことで、会話の要点(特に感情の流れ)だけをメモリに残します。

一方、Shinwariらの手法では、LRU(最近使われていないメモリの削除)だけでなく関連度スコアに基づくプルーニングを導入し、「最近ではないが重要な発話」を残す工夫をしています。

疑似感情メモリの活用

近藤(2025)は、Plutchikの感情モデルを活用してユーザー発話から主要な感情を抽出し、それを短期・長期メモリに格納するアーキテクチャを提案しました。

このシステムは蓄積したユーザーの感情パターンに基づきAIの擬似的な感情状態やパーソナリティを変化させることで、時間経過による応答内容・口調の変化を生み出します。実験では、この「感情メモリ」を参照することで応答に明確な変化が現れ、対話履歴に基づきAIが感情面で成長・変化する可能性が示されています。

共感性を評価する指標とデータセット

EmpatheticDialoguesデータセット

対話AIの共感的応答を評価するには、従来のBLEUやROUGEといった指標だけでは不十分です。

EmpatheticDialoguesは、32種類の感情カテゴリに分類された約25,000件の対話から成り、「ある感情状況に対する共感的応答」を学習・評価する基盤となっています。Rashkinら(2019)の研究では、このデータセットで学習したモデルの方が人間評価で共感的と感じられる確率が高いことが示されました。

多次元評価フレームワーク

Hongら(2025)は、**Sentiment(感情極性)とEmotion(細分化された感情対応度)の2つの観点にSemantic(文脈適合性)**を組み合わせた新たな評価フレームワークを提案しました。

具体的には以下のコンポーネントで構成されています:

- SenticLink:感情極性の一致度を測定

- NEmpathySort:モデル応答の感情表出の多様性と適切性を評価

- EmoSight:微細な感情対応を測定

- 文脈的一貫性指標:RAGASに基づく

このような多次元評価により、モデル応答の共感性を強度・ニュアンス両面から捉えることができます。

人間による評価の重要性

自動評価指標が整備されつつあるとはいえ、人間評価は依然として不可欠です。研究では、クラウドソーシングなどで人間アノテータが応答ごとに「共感できるか」「適切か」「感情に寄り添っているか」といった尺度で評点することが一般的です。

共感性、関連性、流暢さの3軸で5段階評価するケースや、A/Bテスト形式で「どちらの応答がより共感的か」を比較する方法も用いられます。

実用化事例:メンタルヘルスから教育まで

メンタルヘルス支援での活用

メンタルヘルス対話エージェントは、ユーザーの感情に寄り添いながら心理的支援を提供することを目的としています。

Emotional Support Conversation(ESC)システムは、ユーザーのストレスや不安を対話を通じて緩和することを狙ったものです。実際に、うつ病傾向のユーザーを対象にチャットボット(Woebotなど)を用いた実験では、ボットが共感的に応答することで不安や抑うつ指標が改善したという報告があります。

医療現場でも、がん患者のピアサポートから得た知見を組み込んだ対話モデルや、セラピストの共感技法を模倣したシステムが試作されています。これらは患者の感情を理解し適切な共感表現を行うことで、患者の不安軽減や満足度向上に寄与する可能性があります。

教育分野での効果

共感能力を備えたロボットや対話エージェントは、学習者のモチベーション向上に有効であることが示されています。

Frontiers誌に掲載された研究では、感情知能と記憶を持つロボット家庭教師が、生徒の感情状態に応じた声かけやジェスチャーを行い、従来型ロボットよりも生徒のエンゲージメント(没入度)を有意に改善しました。

このようなエージェントは、生徒が落胆した際には励まし、成功した際には喜びを共有するといった情動的フィードバックを返します。結果として、生徒はロボットに対し親しみと信頼を感じ、積極的に学習へ取り組む姿勢が引き出されました。

介護・福祉分野での可能性

高齢者の会話相手となるコンパニオンAIも登場しています。家庭用対話ロボットElliQは高齢者に話しかけて日々の心境を伺い、孤独感の軽減に寄与しているという事例があります。

AIが共感的に相槌を打ったり思い出話に共感を示すことで、ユーザーは「自分を理解してくれる存在」と感じ、精神的サポートにつながります。一部の介護施設で導入された共感対話システムが入居者の抑うつスコアを改善したという報告もあり、今後のエビデンス蓄積が期待されます。

倫理的・技術的課題

記憶の更新と削除の問題

対話AIが蓄積したユーザーデータや記憶をどのように更新し、必要に応じて削除するかは重要な課題です。

ユーザーが「以前の会話内容を忘れてほしい」と求めた場合、モデルのメモリからそれを確実に消去できる仕組みが必要です。しかし一度学習・保存した情報を消し去るのは容易ではなく、機械学習における「忘れさせる権利(right to be forgotten)」の技術はまだ発展途上です。

誤記憶と幻覚のリスク

モデルが過去の事実関係やユーザー情報を不正確に想起する誤記憶の問題もあります。

長期メモリを持つシステムでは、保存した知識が古くなったり誤っていた場合に、AIがそれを正しいと信じ込んで応答に利用してしまう危険があります。これは大規模モデルにおける幻覚(hallucination)の一種であり、特に長い対話の文脈で断片的な記憶だけを頼りに応答すると事実誤認が起きやすくなります。

さらに、AIがユーザーについて推論したこと(例:「このユーザーは寂しがり屋だ」)を記憶し、それが誤っている場合、後の対話で不適切な対応をするリスクもあります。

プライバシーとのトレードオフ

長期記憶を充実させるほど、AIはユーザーに最適化された便利な応答が可能になりますが、その反面ユーザーのプライバシーリスクが高まります。

AIエージェントがユーザーのあらゆるやり取りや個人情報を記憶し続けるならば、万一それが漏洩した場合の影響は甚大です。また、ユーザー自身「忘れてほしい過去」までAIが覚えていることに不快感を抱く可能性もあります。

便利さとプライバシー保護のせめぎ合いの中で、どの程度の記憶保持が適切かは社会的合意が必要です。

共感の限界と依存のリスク

共感的対話AIが高度になるほど、ユーザーはAIをあたかも人間のように信頼し、深い悩みを打ち明ける可能性があります。

しかし現在のAIは本当の意味で感情を経験しているわけではなく、共感もシミュレーションに過ぎません。そのギャップがユーザーに害を及ぼすリスク(例えばAIからの共感に依存しすぎる、あるいはAIの応答に不満を感じ心理的ショックを受けるなど)も指摘されています。

特にメンタルヘルス用途では、AIが誤った対応をした場合の責任や、ユーザーがAIにプライバシーを明かしすぎる問題など、解決すべき倫理課題が山積しています。

まとめ:人間とAIの共生に向けて

長期記憶機能と共感的一貫性を備えたAI対話システムは、メモリ拡張型ニューラルネットワーク、RAG、感情トラッキング、ユーザープロファイル記憶といった技術の進化により、着実に実現に近づいています。

メンタルヘルス支援、教育、介護など様々な分野での応用が始まっており、実際に人々の生活の質向上に寄与する可能性を示す成果が報告されています。一方で、記憶の管理、誤記憶、プライバシー、依存リスクといった課題も明らかになっており、技術的ソリューションと社会的ルールの両面から慎重に対処する必要があります。

今後、モデルのコンテキストウィンドウがさらに拡大し、外部知識ベースとの統合が進めば、対話AIの長期記憶能力は飛躍的に高まるでしょう。同時に、ユーザーとの信頼関係を維持するための倫理指針策定や、ユーザーデータを安全に扱うガバナンスも一層重要になります。

人間とAIの共生を目指す上で、長期記憶と共感というテーマは今後も中心的な研究課題であり続けるでしょう。

コメント