なぜ対話AIの個人化と一貫性が重要なのか

生成AI、特に大規模言語モデル(LLM)を活用した対話システムは、教育、医療、カスタマーサポートなど多様な領域で実用化が進んでいます。しかし、すべてのユーザーに同じ説明を提供する画一的なアプローチでは、個々のニーズに応えきれません。ユーザーは情報の受け取り方や理解の仕方に違いがあり、それぞれの認知スタイルに合わせた説明が理解促進や信頼醸成につながります。

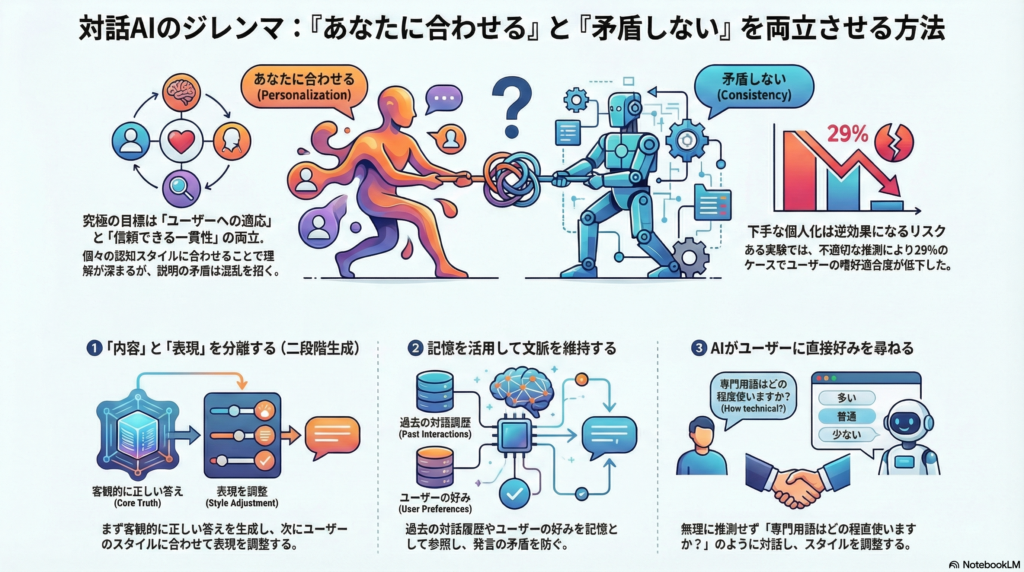

一方で、ユーザーに合わせて説明を変化させすぎると、論理的な整合性や一貫性が損なわれるリスクがあります。前回と今回で説明の切り口が変わったり、内容が矛盾したりすれば、ユーザーの混乱や不信感を招きかねません。本記事では、このパーソナライゼーションと説明の一貫性のバランスをいかに取るかについて、最新の研究知見と実装アプローチを解説します。

説明の一貫性とは:定義と重要性

一貫性の3つの側面

対話エージェントにおける「説明の一貫性」とは、以下の3つの要素を指します。

内的な論理整合性

説明内容が内部で矛盾せず、筋道が通っていること。例えば「Aだから」と説明した直後に「Bだから実はAではない」といった論理破綻がないことです。

時系列での一貫性

過去の説明や発言と矛盾しないこと。対話履歴の中で以前述べた事実や結論と食い違わないよう保つことが重要です。

事実との整合性(Faithfulness)

モデルの内部推論や実際の事実と矛盾しない説明であること。これは広義の一貫性として、説明可能AI(XAI)研究でも重視されています。

なぜ一貫性が重要か

説明の一貫性を維持することで、ユーザーは安心してエージェントの説明を信頼できます。特に教育分野では、安定した理解を積み重ねるために論理的な繋がりが不可欠です。研究では、説明の一貫性を「類似した質問に対して類似した論理展開で説明できること」と定義し、これが学習効果に直結することが示されています。

逆に、個人化を重視するあまり説明がぶれると、ユーザーの混乱を招きます。医療分野などでは、正確さと患者への配慮の両立が求められるため、一貫性の維持はさらに重要になります。

ユーザーの認知スタイルに基づく個人化

認知スタイルとは

認知スタイルとは、情報処理の傾向や好みを指し、認知心理学では次のような分類が提案されています。

- 論理型 vs 直感型:分析的に処理するか、直感的に全体像を掴むか

- 視覚型 vs 言語型:画像・図表で理解しやすいか、文章・音声を好むか

- 活動型 vs 内省型:実践を通じて学ぶか、じっくり考える方を好むか

これらは個人の情報処理における一貫した傾向であり、対話AIが適切に適応できれば、理解度や満足度の向上が期待できます。

ユーザーモデルの獲得方法

ユーザーの認知スタイルを把握するには、明示的手法と暗黙的手法があります。

明示的手法

質問紙やアンケートによって直接測定する方法です。教育分野ではFelder-Silverman学習スタイルモデル(FSLSM)が広く知られており、「直列型/全体型」「感覚型/直観型」など4軸で学習者をプロフィール化できます。

暗黙的手法

ユーザーの対話履歴や行動ログから好みを推定する方法です。LLMでは、過去の会話内容から専門知識レベルや反応傾向を推論し、それを埋め込みベクトルやプロンプトに反映させます。例えば、過去の発話をエピソード記憶、ユーザーの信念や好みをセマンティック記憶として保持するフレームワークが提案されています。

認知スタイルに応じた適応

実験的に、論理型か直感型かによって理解しやすい説明の種類(例示ベース vs ルールベース)が異なることが報告されています。例えば:

- 直感型ユーザー:比喩や具体例から入る直観的アプローチが効果的

- 論理型ユーザー:体系立てた根拠や原理からの演繹的説明を好む

- 視覚型ユーザー:図や動画を用いた説明でエンゲージメントが高まる

ただし、視覚型・言語型の区別については「学習内容に応じたデザインが重要」との指摘もあり、画一的な適用は避けるべきです。

個人化と一貫性のトレードオフ:課題と解決策

トレードオフの実態

パーソナライゼーションと説明の一貫性は、ときに相反します。2025年の研究では、「Personalized Reasoning(個人化推論)」という課題が定義され、モデルの正確性とユーザー嗜好適合の両立が必要とされています。

実験結果によると、事前にユーザー情報がない状況でモデルがニーズを推測すると、29%のケースでむしろユーザー嗜好への適合度が低下しました。つまり、下手に個人化しようとして失敗するケースが多いのです。一方、何も個人化しない汎用的回答も多くの場合ユーザーの真のニーズを満たせません。現在のLLMはこのバランスを上手く取れないため、専用の制御機構が必要だと結論づけられています。

多目的最適化によるバランス

このトレードオフを解消する理論枠組みとして、複数目的の最適化が提案されています。具体的には、モデルの目標関数にタスクの正解率とユーザー満足度(嗜好適合度)の両方を組み込み、重み付けによってバランスを取るアプローチです。

この「ジョイント目的」という考え方では、「高品質な個人化応答には客観的正確さとユーザー嗜好への適合の両方が必要」と明示されており、両観点を評価しながら最善の妥協点を見つけることが可能になります。

二段階生成プロセス

もう一つの有効なアプローチが二段階の生成プロセスです。

- 第一段階:モデルにタスクに対する客観的に正しい説明を考えさせる(詳細な推論を行う)

- 第二段階:ユーザーに適した表現に言い換える

第一段階の推論内容を保持しておけば、第二段階で言い回しを変えても内容の一貫性は保証されます。2025年の「Behavioral Prompting」研究では、タスク内容と話し方(パーソナリティ)を切り離して制御するフレームワークが提案されており、「What(何を言うか)」と「How(どう言うか)」を明確に区別できます。

対話的な嗜好のelicitation

ユーザーの好みが不明な状態で無理に推測するのではなく、モデルがユーザーに直接質問して確認する方法も有効です。例えば「専門的な用語はどの程度理解されていますか?」と尋ね、その回答に応じて説明スタイルを調整します。

ただし、問いかけすぎると対話効率が下がるため、実験では「限られた質問回数で最大のユーザー情報を引き出す戦略」が今後の課題とされています。

バランスを取るための実装アプローチ

動的ペルソナ適応

対話中にエージェントの人格や話し方をユーザーに合わせて逐次更新する手法です。2024年の研究では「自己進化型パーソナライズ対話エージェント」が提案され、階層的な人格更新によって整合性を維持しています。

具体的には:

- 属性レベルの微調整:既存の事実(例:「職業=エンジニア」)を保持しつつ、口調や趣味の話題を徐々に追加

- プロファイル全体の再最適化:対話が進んでから詳細な設定を付け加える

この二段階アプローチにより、「その場でのユーザー合わせ」と「人格の一貫性維持」を両立できます。

記憶ベース個人化

ユーザーとの過去対話をエピソード記憶、ユーザーの信念・嗜好をセマンティック記憶として保持し、応答生成時に参照する方法です。2025年のPRIME研究では、長期・短期記憶を統合したモデルが提案されています。

記憶を常に参照することで、ユーザーごとの文脈に整合した内容を提供し、過去の発言とも食い違わないよう一貫性を確保できます。

メタプロンプト手法

ユーザープロファイルモデル(LoRAなど)からパーソナリティ指令を生成し、ユーザーの質問と統合した「メタプロンプト」を構築する方法です。LLMに対し「何を回答するか」と「どう回答するか(スタイル)」を分離して与えます。

この手法では、どんな問いでも人格的スタイルがブレないよう保証される一方、タスク本来の回答は影響を受けにくくなります。対話全体で安定した口調・態度を維持でき、ユーザーは一貫したキャラクターから説明を受け取れます。

教育的対話モデル

2025年のPELICANシステムでは、二段階の教育対話が実装されています。

- 第一段階:対話的に認知診断(生徒の理解度や誤解を質問で特定)

- 第二段階:診断結果に基づき教授方略を動的選択(例え話、問題分解など)

学生の回答を常にモニタリングしてフィードバックを与え、理解度に応じて方略を調整することで一貫した指導フローを維持しています。実験では、批判的思考が18.7%向上、課題完了率も22.4%改善したと報告されています。

実用例と応用分野

対話型学習支援

教育分野では、学生モデルを推定してから適切な説明戦略を動的に選ぶチュータリングAIが実装されています。数学問題で誤答した学生に対し、その誤りの原因に合わせてヒントを与えたり、関連する基礎概念を別の表現で説明したりすることで、個人化によって学習者の認知を適切に支援し、一貫した対話でモチベーションを維持できます。

パーソナライズド対話エージェント

感情支援対話など長期的な対話でユーザーに寄り添う試みも進んでいます。会話の中でユーザーが技術的な話題を好むと分かったら、エージェントも徐々に技術者らしい話題を増やすなど、人格を調整します。実験対話では、動的適応を行わない静的ペルソナのエージェントよりもユーザー評価スコアが向上し、特に長期利用時のエンゲージメントや信頼感が高まることが示されています。

Explainable AIにおける説明切替

XAIシステムでもユーザータイプ別の説明提供が研究されています。金融の意思決定支援AIにおいて、エキスパートには詳細な数値根拠やルールベースの説明を、非専門家には平易な言葉と具体例による説明を提示するといった具合です。実験では、ルールベース説明 vs 事例ベース説明のどちらが効果的かはユーザーの認知スタイルによって有意に異なることが報告されています。

医療・ヘルスケア対話

医療分野では、患者の知識や不安の度合いに応じて説明を変えるAIが求められています。医学知識のある患者には専門用語で正確に説明し、不安の強い患者には共感を示しつつ平易な比喩で説明する対応が必要です。このケースでは命に関わる正確さと患者の安心感の両立が極めて重要であり、常に説明の一貫性・正確さチェック(医療知識グラフに基づく検証など)を組み合わせる必要があります。

まとめ:個人化と一貫性の両立に向けて

対話AIにおけるパーソナライゼーションは、より自然で効果的なコミュニケーションを実現する上で欠かせません。同時に、AIの提示する説明が常に筋道立って矛盾なく展開されることも、ユーザーの信頼と理解を得るために極めて重要です。

本記事で紹介した研究や実装例は、この両者のバランスをとるための様々なアプローチを示しています。マルチモーダルなユーザーモデルの活用、推論過程と提示様式の分離、対話を通じた嗜好獲得、段階的な適応戦略など、複数の角度からの工夫が重ねられており、それぞれ一定の有効性が報告されています。

しかし、この分野はまだ新しく、課題も残されています。ユーザーのプライバシーに配慮しながら長期的なユーザーモデルを更新する方法、過度の個人化によるバイアスや情報フィルターバブルを避ける手法、説明の一貫性を客観的に評価する指標の確立などが今後の研究課題です。

対話型AIが教育・医療・日常生活の幅広い場面で活用されていくにつれ、個人化と一貫性のバランス制御はますます重要な基盤技術になるでしょう。ユーザー一人ひとりに信頼され有益となるAI対話システムの実現に向けて、本記事で述べた知見が実装の参考になれば幸いです。

コメント